รายชื่อโปรแกรมรวบรวมข้อมูลเว็บ: 10 อันดับโปรแกรมรวบรวมข้อมูลเว็บที่พบบ่อยที่สุดในปี 2024

เผยแพร่แล้ว: 2023-12-09คุณเคยประสบปัญหาในการทำให้เว็บไซต์ของคุณเป็นแบบไดนามิกและเป็นมิตรกับ SEO ด้วยการอัปเดตอย่างต่อเนื่องหรือไม่? เมื่อต้องจัดการกับหน้าหลายร้อยหรือหลายพันหน้า การผลักดันการอัปเดตไปยังเครื่องมือค้นหาด้วยตนเองกลายเป็นเรื่องที่ท้าทาย คำถามสำคัญคือ: คุณจะแน่ใจได้อย่างไรว่าการอัปเดตเนื้อหาบ่อยครั้งจะส่งผลเชิงบวกต่อการจัดอันดับ SEO วิธีแก้ปัญหาอยู่ที่บอทของซอฟต์แวร์รวบรวมข้อมูล บอทเหล่านี้ จะขูดแผนผังไซต์ของคุณ สร้างดัชนีการอัปเดตใหม่ และมีบทบาทสำคัญในการปรับปรุง SEO ในบล็อกนี้ เราได้รวบรวมรายชื่อโปรแกรมรวบรวมข้อมูลเว็บที่จะทำให้งานของคุณง่ายและราบรื่น

โปรแกรมรวบรวมข้อมูลเว็บคืออะไร & มันทำงานอย่างไร?

โปรแกรมรวบรวมข้อมูลเว็บคือโปรแกรมคอมพิวเตอร์อัตโนมัติที่ออกแบบมาเพื่อการดำเนินการซ้ำๆ โดยเฉพาะการนำทางและจัดทำดัชนีเอกสารออนไลน์ เครื่องมือค้นหาเช่น Google มักใช้เพื่อทำให้การเรียกดูอัตโนมัติและสร้างดัชนีเนื้อหาเว็บ คำว่า 'crawler' มีความหมายเหมือนกันกับ 'Bot' หรือ 'Spider' และ Googlebot ก็เป็นตัวอย่างที่รู้จักกันดี

คำถามมาถึงแล้ว โปรแกรมรวบรวมข้อมูลเว็บทำงานอย่างไร

โปรแกรมรวบรวมข้อมูลเว็บเริ่มต้นด้วยการดาวน์โหลด ไฟล์ robot.txt ของเว็บไซต์ ซึ่งมีแผนผังไซต์ที่แสดง URL ที่มีสิทธิ์ในการรวบรวมข้อมูล ขณะที่นำทางไปยังหน้าต่างๆ โปรแกรมรวบรวมข้อมูลจะระบุ URL ใหม่ผ่านไฮเปอร์ลิงก์ และเพิ่มลงในคิวการรวบรวมข้อมูลสำหรับการสำรวจที่เป็นไปได้ในภายหลัง

โปรแกรมรวบรวมข้อมูลเว็บประเภทต่างๆ: โดยสรุป

การสร้างการรวบรวมหมวดหมู่โปรแกรมรวบรวมข้อมูลเว็บเกี่ยวข้องกับการจำแนกประเภทหลักสามประเภท: โปรแกรมรวบรวมข้อมูลเว็บภายใน บริษัท โปรแกรม รวบรวมข้อมูลเว็บเชิงพาณิชย์ และ โปรแกรมรวบรวมข้อมูลเว็บแบบโอเพ่นซอร์ส เรามาทำความรู้จักกับโปรแกรมรวบรวมข้อมูลเว็บเหล่านี้ ก่อนที่จะดำดิ่งลงสู่รายการโปรแกรมรวบรวมข้อมูลเว็บขั้นสุดยอด

โปรแกรมรวบรวมข้อมูลเว็บภายใน: เครื่องมือโปรแกรมรวบรวมข้อมูลเว็บเหล่านี้สร้างขึ้นภายในโดยองค์กรต่างๆ เพื่อนำทางผ่านเว็บไซต์เฉพาะของตน โดยให้บริการตามวัตถุประสงค์ที่หลากหลาย เช่น การสร้างแผนผังเว็บไซต์ และการสแกนหา ลิงก์ที่ใช้งานไม่ได้

โปรแกรมรวบรวมข้อมูลเว็บเชิงพาณิชย์: เครื่องมือโปรแกรมรวบรวมข้อมูลเว็บเชิงพาณิชย์เป็นเครื่องมือที่สามารถเข้าถึงได้ในตลาดเพื่อซื้อ และ โดยทั่วไปจะได้รับการพัฒนาโดยบริษัท ที่เชี่ยวชาญด้านซอฟต์แวร์ดังกล่าว นอกจากนี้ บริษัทที่มีชื่อเสียงบางแห่งอาจจ้างสไปเดอร์ที่ออกแบบเป็นพิเศษซึ่งปรับให้เหมาะกับข้อกำหนดในการรวบรวมข้อมูลเว็บไซต์เฉพาะของบริษัท

โปรแกรมรวบรวมข้อมูลเว็บแบบโอเพ่นซอร์ส: ในทางกลับกัน โปรแกรมรวบรวมข้อมูลแบบโอเพ่นซอร์สนั้นมีให้บริการแก่สาธารณะภายใต้ใบอนุญาตแบบฟรี/แบบเปิด ซึ่งช่วยให้ผู้ใช้สามารถใช้งานและปรับเปลี่ยนได้ตามความต้องการ

แม้ว่าอาจขาดคุณสมบัติขั้นสูงบางอย่างที่มีอยู่ในเวอร์ชันเชิงพาณิชย์ แต่ก็เปิดโอกาสให้ผู้ใช้เจาะลึกซอร์สโค้ด และรับข้อมูลเชิงลึกเกี่ยวกับกลไกของการรวบรวมข้อมูลเว็บ

รายชื่อ Web Crawler ที่คอมไพล์แล้ว: รายการที่พบบ่อยที่สุดในปี 2024

ไม่มีโปรแกรมรวบรวมข้อมูลใดที่ได้รับการออกแบบมาเพื่อจัดการปริมาณงานทั้งหมดสำหรับเครื่องมือค้นหาทุกรายการ แต่กลับมีโปรแกรมรวบรวมข้อมูลเว็บที่หลากหลายเพื่อประเมินเนื้อหาของหน้าเว็บของคุณ สแกนเนื้อหาเหล่านั้นเพื่อประโยชน์ของผู้ใช้ทั่วโลก และตอบสนองความต้องการที่แตกต่างกันของเครื่องมือค้นหาต่างๆ ตอนนี้ให้เราเจาะลึกรายการโปรแกรมรวบรวมข้อมูลเว็บที่ใช้อยู่ในปัจจุบัน

Googlebot

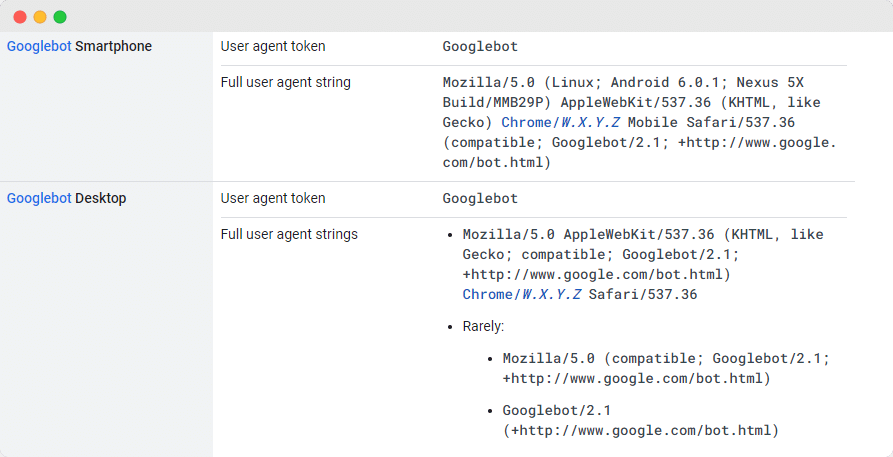

Googlebot ซึ่งเป็นเครื่องมือรวบรวมข้อมูลเว็บทั่วไปจาก Google มีบทบาทสำคัญในการสแกนเว็บไซต์เพื่อรวมไว้ในเครื่องมือค้นหาของ Google แม้ว่าในทางเทคนิคจะมีสองเวอร์ชัน ได้แก่ Googlebot Desktop และ Googlebot Smartphone (อุปกรณ์เคลื่อนที่) แต่ผู้เชี่ยวชาญหลายคนถือว่าเวอร์ชันเหล่านี้เป็นเพียงโปรแกรมรวบรวมข้อมูลเดียว

ความสามัคคีนี้ได้รับการดูแลผ่านโทเค็นผลิตภัณฑ์ที่ไม่ซ้ำที่ใช้ร่วมกัน (เรียกว่าโทเค็นตัวแทนผู้ใช้) ที่ระบุไว้ใน robots.txt ของแต่ละไซต์ โดยตัวแทนผู้ใช้เป็นเพียง 'Googlebot'

Googlebot เข้าถึงไซต์ของคุณเป็นประจำ โดยปกติทุกๆ สองสามวินาที เว้นแต่จะมีการบล็อกโดยเจตนาใน robots.txt ของไซต์ หน้าที่สแกนจะถูกจัดเก็บไว้ในฐานข้อมูลส่วนกลางที่เรียกว่า Google Cache ซึ่งช่วยให้คุณสามารถตรวจสอบเวอร์ชันที่ผ่านมาของไซต์ของคุณได้

ยานเดกซ์บอท

Yandex Spider เป็นหนึ่งในเครื่องมือรวบรวมข้อมูลเว็บที่ดีที่สุดที่ออกแบบมาโดยเฉพาะสำหรับแพลตฟอร์มการค้นหาของรัสเซีย Yandex ซึ่งเป็นหนึ่งในเครื่องมือค้นหาที่สำคัญและใช้กันอย่างแพร่หลายในรัสเซีย ผู้ดูแลเว็บไซต์มีตัวเลือกในการให้สิทธิ์การเข้าถึง Yandex Spider โดยการกำหนดค่าหน้าของเว็บไซต์ในไฟล์ robots.txt

นอกจากนี้ พวกเขาสามารถปรับปรุงการเข้าถึงโดยการรวมแท็ก Yandex.Metrica บนหน้าที่เลือก อัปเดตการจัดทำดัชนีหน้าผ่านเครื่องมือ Yandex Webmaster หรือใช้โปรโตคอล IndexNow ซึ่งเป็นรายงานพิเศษที่ระบุหน้าใหม่ ที่ถูกเปลี่ยนแปลง หรือปิดใช้งาน

ดั๊กดัคบอท

DuckDuckBot ทำหน้าที่เป็นโปรแกรมรวบรวมข้อมูลเครื่องมือค้นหาสำหรับ DuckDuckGo รับประกันความเป็นส่วนตัวบนอินเทอร์เน็ตเบราว์เซอร์ของคุณ เจ้าของเว็บไซต์สามารถเข้าถึง DuckDuckBot API เพื่อตรวจสอบว่าไซต์ของตนได้รับการรวบรวมข้อมูลหรือไม่

ในระหว่างกระบวนการนี้ DuckDuckBot จะอัปเดตฐานข้อมูล API ด้วยที่อยู่ IP และตัวแทนผู้ใช้ใหม่ ช่วยเหลือเว็บมาสเตอร์ในการตรวจจับผู้แอบอ้างหรือบอทที่เป็นอันตรายที่พยายามเชื่อมต่อกับ DuckDuckBot

บิงบอต

ในปี 2010 Microsoft ได้พัฒนา Bingbot เพื่อวิเคราะห์และจัดทำแคตตาล็อก URL เพื่อให้มั่นใจว่า Bing มอบผลการค้นหาที่เกี่ยวข้องและเป็นปัจจุบัน เช่นเดียวกับ Googlebot เจ้าของเว็บไซต์สามารถระบุใน robots.txt ได้ว่าอนุญาตหรือไม่อนุญาตให้ ' bingbot ' สแกนไซต์ของตน

นอกจากนี้ นักพัฒนายังสามารถแยกความแตกต่างระหว่างโปรแกรมรวบรวมข้อมูลการจัดทำดัชนีที่เน้นอุปกรณ์เคลื่อนที่เป็นอันดับแรกและโปรแกรมรวบรวมข้อมูลบนเดสก์ท็อป เนื่องจาก Bingbot เพิ่งนำเอเจนต์ประเภทใหม่มาใช้ เมื่อรวมกับ Bing Webmaster Tools แล้ว จะทำให้เว็บมาสเตอร์มีความยืดหยุ่นมากขึ้นในการนำเสนอวิธีการค้นพบและแสดงไซต์ของตนในผลการค้นหา

แอปเปิ้ลบอท

Apple ได้ริเริ่มการพัฒนา Apple Bot เพื่อสแกนและจัดทำแคตตาล็อกหน้าเว็บเพื่อใช้งานร่วมกับ Siri และคำแนะนำโดย Spotlight ของ Apple Apple Bot ประเมินเกณฑ์ต่างๆ เพื่อกำหนดเนื้อหาที่จะจัดลำดับความสำคัญในคำแนะนำโดย Siri และ Spotlight

เกณฑ์เหล่านี้เกี่ยวข้องกับการโต้ตอบของผู้ใช้ ความสำคัญของข้อความค้นหา ปริมาณและคุณภาพของลิงก์ สัญญาณตามสถานที่ตั้ง และการออกแบบโดยรวมของหน้าเว็บ

แมงมุมโซโก

Sogou ซึ่งเป็นเสิร์ชเอ็นจิ้นของจีน ได้รับการยอมรับว่าเป็นแพลตฟอร์มการค้นหาเบื้องต้นที่มีการจัดทำดัชนีหน้าเว็บภาษาจีนถึง 10 พันล้านหน้า สำหรับผู้ที่มีส่วนร่วมในกิจกรรมทางการตลาดของจีน การตระหนักถึงโปรแกรมรวบรวมข้อมูลเสิร์ชเอ็นจิ้นที่ใช้กันอย่างแพร่หลายนี้ Sogou Spider ถือเป็นสิ่งสำคัญ เป็นไปตามข้อความการแยกโรบ็อตและการตั้งค่าการหน่วงเวลาการรวบรวมข้อมูล

เช่นเดียวกับ Baidu Spider หากธุรกิจของคุณไม่ได้กำหนดเป้าหมายไปที่ตลาดจีน เราขอแนะนำให้คุณปิดการใช้งาน Spider นี้เพื่อหลีกเลี่ยงการโหลดเว็บไซต์ที่เชื่องช้า

ไป่ตู้แมงมุม

เครื่องมือค้นหาหลักในประเทศจีนคือ Baidu และโปรแกรมรวบรวมข้อมูลพิเศษคือ Baidu Spider เนื่องจากไม่มี Google ในประเทศจีน การอนุญาตให้ Baidu Spider รวบรวมข้อมูลเว็บไซต์ของคุณจึงเป็นเรื่องสำคัญหากคุณตั้งเป้าที่จะกำหนดเป้าหมายไปที่ตลาดจีน หากต้องการจดจำกิจกรรมของ Baidu Spider บนไซต์ของคุณ ให้ตรวจสอบตัวแทนผู้ใช้ เช่น baiduspider, baiduspider-image, baiduspider-video และอื่นๆ

สำหรับผู้ที่ไม่ได้มีส่วนร่วมในกิจกรรมทางธุรกิจของจีน อาจสมเหตุสมผลที่จะบล็อก Baidu Spider โดยใช้สคริปต์ robots.txt ของคุณ การทำเช่นนี้จะทำให้คุณสามารถป้องกันไม่ให้ Baidu Spider สแกนไซต์ของคุณได้ และลดโอกาสที่หน้าเว็บของคุณจะปรากฏบนหน้าผลลัพธ์ของโปรแกรมค้นหา (SERP) ของ Baidu

สเลอปบอท

Slurp Bot โรบอตการค้นหาของ Yahoo มีบทบาทสำคัญในการรวบรวมข้อมูลและจัดทำดัชนีหน้าเว็บ ไม่เพียงแต่สำหรับ Yahoo.com เท่านั้น แต่ยังรวมถึงแพลตฟอร์มในเครือ เช่น Yahoo News, Yahoo Finance และ Yahoo Sports

การไม่มีการรวบรวมข้อมูลนี้จะส่งผลให้ไม่มีรายการเว็บไซต์ที่เกี่ยวข้อง ประสบการณ์เว็บส่วนบุคคลสำหรับผู้ใช้ซึ่งมีผลลัพธ์ที่เกี่ยวข้องมากขึ้นเกิดขึ้นได้จากการมีส่วนร่วมของเนื้อหาที่จัดทำดัชนี

การโจมตีภายนอกของ Facebook

โปรแกรมรวบรวมข้อมูล Facebook หรือที่เรียกว่า Facebook ภายนอก Hit จะตรวจสอบ HTML ของเว็บไซต์หรือแอพที่แชร์บน Facebook มีหน้าที่สร้างการแสดงตัวอย่างลิงก์ที่แชร์บนแพลตฟอร์ม โดยแสดงชื่อ คำอธิบาย และภาพขนาดย่อ

การรวบรวมข้อมูลต้องเกิดขึ้นทันที เนื่องจากความล่าช้าอาจส่งผลให้ส่วนย่อยที่กำหนดเองไม่แสดงเมื่อมีการแชร์เนื้อหาบน Facebook

สวิฟต์บอท

เครื่องมือค้นหาส่วนบุคคล Swiftype ปรับปรุงฟังก์ชันการค้นหาของเว็บไซต์ของคุณโดยการบูรณาการเทคโนโลยีชั้นยอด อัลกอริธึม เฟรมเวิร์กการนำเข้าเนื้อหา ไคลเอนต์ และเครื่องมือวิเคราะห์ Swiftype มอบอินเทอร์เฟซที่เป็นมิตรต่อผู้ใช้เพื่อจัดทำแคตตาล็อกและจัดทำดัชนีทุกหน้าอย่างมีประสิทธิภาพ เป็นประโยชน์อย่างยิ่งต่อเว็บไซต์ที่มีหน้าจำนวนมาก

Swiftbot ซึ่งเป็น โปรแกรมรวบรวมข้อมูลเว็บของ Swiftype มีบทบาทสำคัญในกระบวนการนี้ โดยเฉพาะอย่างยิ่ง Swiftbot สร้างความโดดเด่นด้วยการรวบรวมข้อมูลไซต์ตามคำขอของลูกค้าโดยเฉพาะ ทำให้แตกต่างจากบอทอื่นๆ

รายการโปรแกรมรวบรวมข้อมูลเว็บอันดับต้น ๆ เพื่อเป็นผู้เชี่ยวชาญ SEO ในปี 2024

รายการโปรแกรมรวบรวมข้อมูลเว็บที่ได้รับการดูแลจัดการซึ่งนำเสนอในบล็อกนี้ทำหน้าที่เป็นทรัพยากรอันมีค่าในการปรับปรุงกระบวนการทำให้ไซต์ของคุณเป็นแบบไดนามิกและเป็นมิตรกับ SEO เมื่อคุณเข้าใกล้ปี 2024 คุณจะต้องรวมเครื่องมือโปรแกรมรวบรวมข้อมูลเว็บที่ดีที่สุดเหล่านี้ไว้ในกลยุทธ์ของคุณเพื่อให้แน่ใจว่าเว็บไซต์ของคุณยังคงอยู่ในแถวหน้าของการจัดอันดับเครื่องมือค้นหา ช่วยให้ทีมมุ่งเน้นไปที่การสร้างเนื้อหาที่มีคุณภาพในขณะที่โปรแกรมรวบรวมข้อมูลจัดการกับความซับซ้อนของการเพิ่มประสิทธิภาพ

หากคุณพบว่าบทความนี้มีประโยชน์ โปรดแบ่งปันกับผู้อื่น นอกจากนี้ อย่าลืม สมัครรับข้อมูลบล็อกของเรา และค้นหาข้อมูลเชิงลึกเพิ่มเติมเช่นนี้เพื่อให้โดดเด่นในการจัดอันดับการค้นหา