Cum să optimizați cu ușurință WordPress Robots.txt?

Publicat: 2023-02-28Introducere

Există numeroase tehnici pentru a crește SEO-ul site-ului dvs. Optimizarea WordPress Robots.txt este una dintre cele mai bune metode. Deoarece le permite motoarelor de căutare să scaneze site-ul dvs., fișierul Robots.txt este binecunoscut ca un instrument SEO puternic. Ca rezultat, puteți îmbunătăți în mod liber SEO-ul site-ului dvs. modificând fișierul Robots.txt. Vom introduce în mod clar câteva abordări pentru optimizarea WordPress Robots.txt pe acest subiect în această postare de blog astăzi.

Definiția fișierului Robots.txt

Mai jos este un rezumat al fișierului Robots.txt al WordPress.

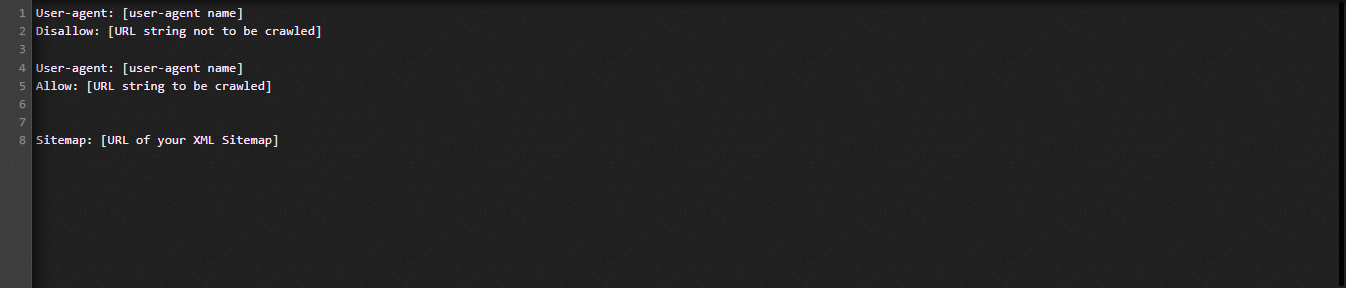

Să aruncăm o privire acum asupra structurii fundamentale a fișierului Robot.txt:

Să definim termenii folosiți în fișierul Robots.txt pentru dvs.:

- User-agent: numele crawler-ului

- Renunțare: împiedică accesarea cu crawlere a paginilor, folderelor sau fișierelor unui site web.

- Permite: activarea accesării cu crawlere a directoarelor, fișierelor și paginilor

- Harta site-ului, dacă este furnizată: Afișați locația hărții site-ului: reprezintă un număr sau o literă.

- *: reprezintă număr sau caracter

- $: îl puteți folosi pentru a restricționa paginile web care includ o anumită extensie, stând până la sfârșitul rândului.

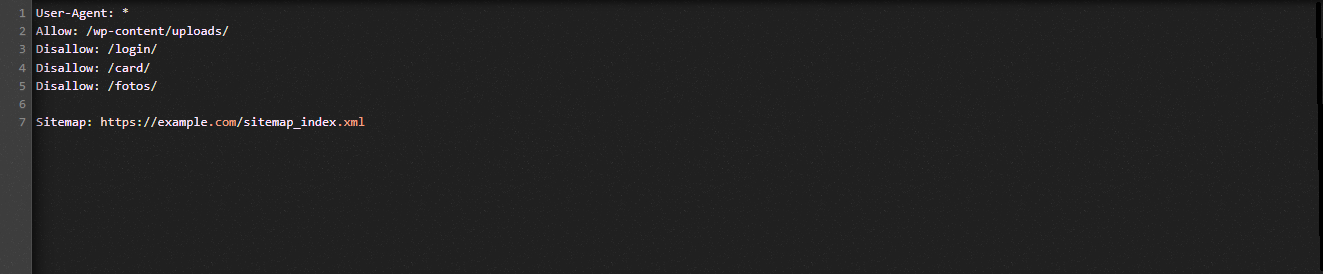

Să ne uităm la următoarea ilustrație pentru a vă ajuta să înțelegeți:

Permitem motoarele de căutare să acceseze cu crawlere fișierele din folderul de încărcări WordPress din exemplul Robot.txt.

Cu toate acestea, restricționăm accesul motoarelor de căutare la dosarele de conectare, card și fotografii.

În cele din urmă, îi oferim adresa URL a sitemap-ului.

De ce ar trebui creat un fișier Robots.txt pentru site-ul dvs. WordPress?

Fără un fișier Robots.txt, motoarele de căutare vor continua să acceseze cu crawlere și să indexeze fiecare pagină a unui site web. Cu toate acestea, ei vor accesa cu crawlere tot materialul de pe site-ul dvs. web, mai degrabă decât doar folderele sau paginile pe care le specificați.

Ar trebui să creați un fișier Robots.txt pentru site-ul dvs. din două motive esențiale. În primul rând, puteți gestiona fără efort toate informațiile de pe site-ul dvs. web cu ajutorul acestuia. Dacă paginile sau directoarele ar trebui accesate cu crawlere sau indexate, depinde de dvs. Înseamnă că pagini precum fișierele plugin, paginile de administrare sau directoarele cu teme nu vor fi accesate cu crawlere de motoarele de căutare. Drept urmare, va ajuta la viteza de încărcare a indexului site-ului dvs.

Cerința de a preveni indexarea postărilor sau paginilor inutile de către motoarele de căutare este cealaltă justificare. Prin urmare, puteți împiedica cu ușurință și convenabil o pagină sau o postare WordPress să apară în rezultatele căutării.

Cum să optimizați WordPress Robots.txt mai eficient

În acest blog cu instrucțiuni, vă vom arăta cum să creați și să îmbunătățiți fișierul Robots.txt pe site-ul dvs. WordPress folosind două metode diferite:

- Efectuarea de modificări în fișierul Robots.txt folosind un plugin: All in One SEO

- Editarea manuală a fișierului Robots.txt cu FTP

Pentru a face fișierul Robots.txt mai eficient, utilizați pluginul All in One SEO.

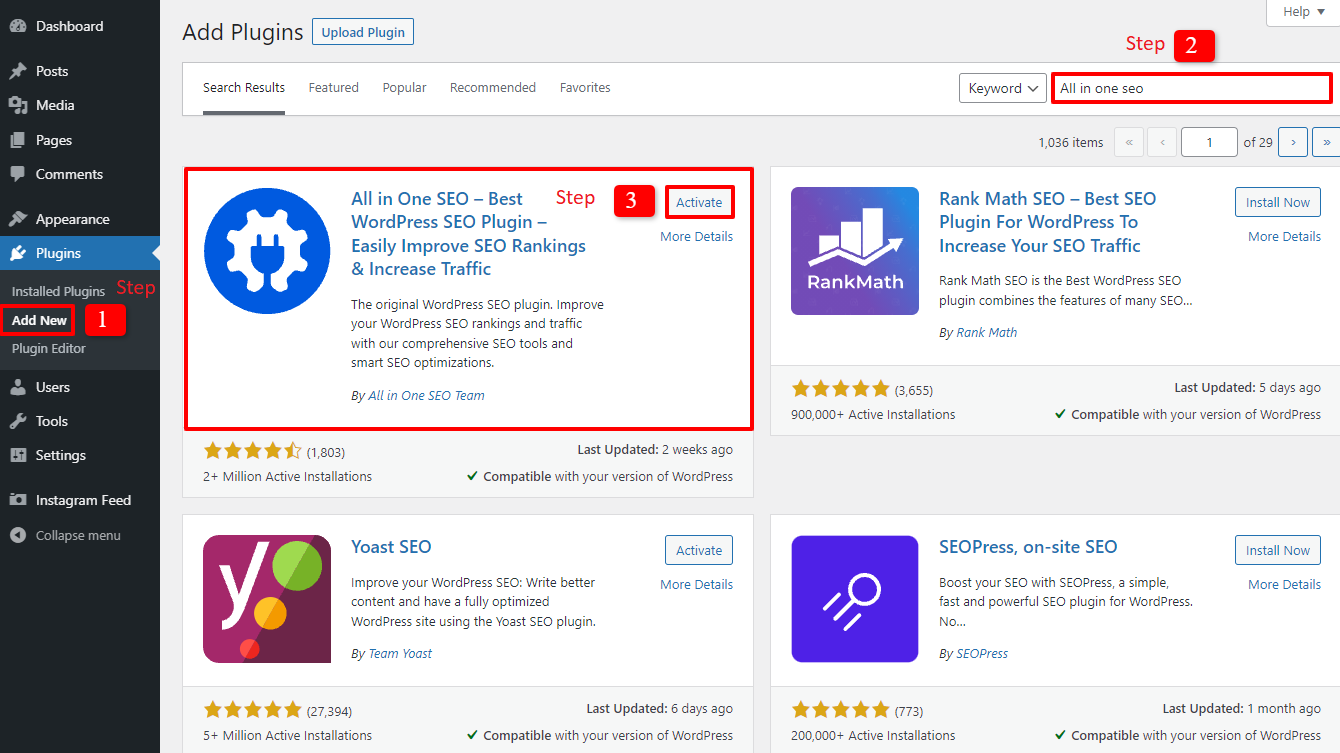

Mai multe pluginuri WordPress SEO sunt disponibile pentru a vă ajuta cu această problemă pe piața WordPress. Însă, în acest articol, am ales să folosim All in One SEO, un plugin foarte apreciat cu peste 2 milioane de utilizatori, pentru a vă ajuta.

Să-l instalăm mai întâi selectând Plugins -> Add New . apoi căutați numele pluginului, instalați -l și apoi activați -l.

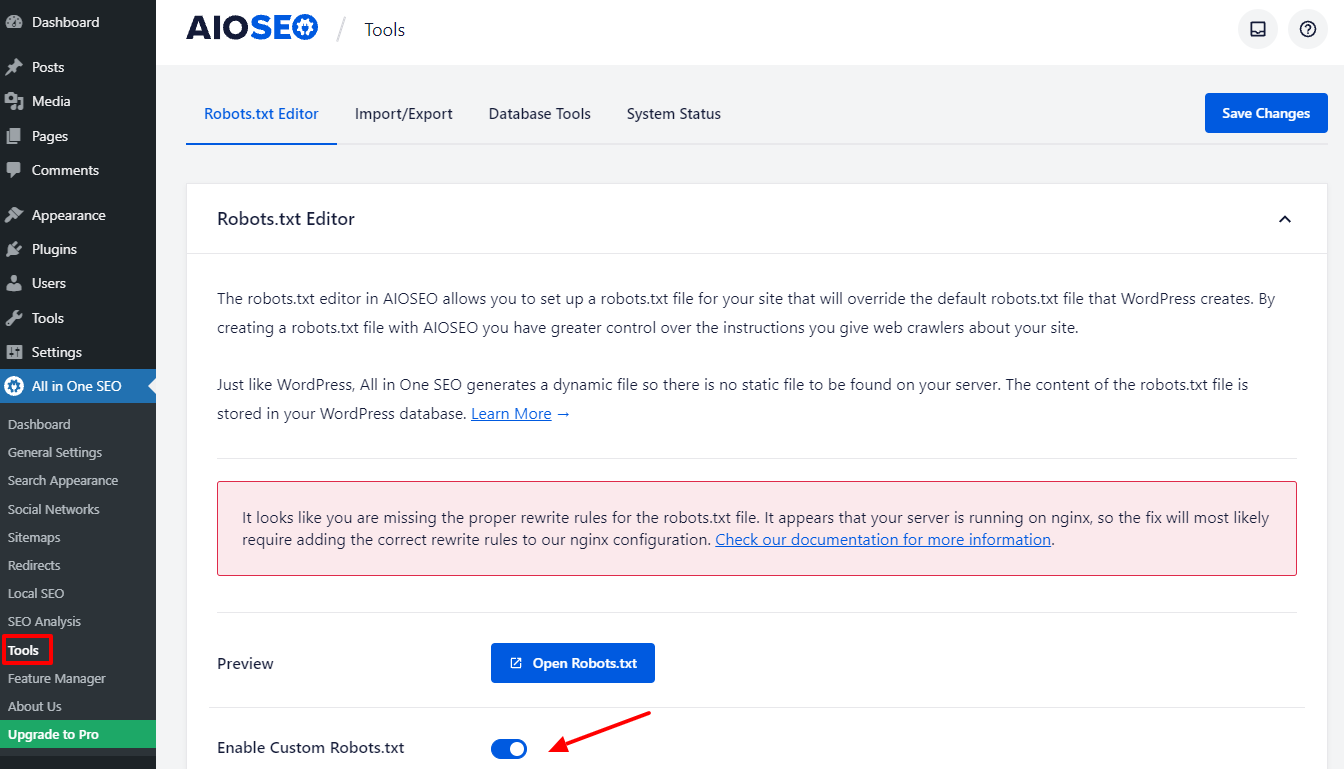

Vei reveni la tabloul de bord administrativ după ce ai parcurs câțiva pași simpli. Accesați All in one SEO -> Instrumente chiar acum.

Să comutăm butonul Enable Custome Robots.txt din secțiunea Robots.txt Editor pentru a-l activa. După ce îl porniți, puteți edita fișierul implicit Robots.txt în WordPress.

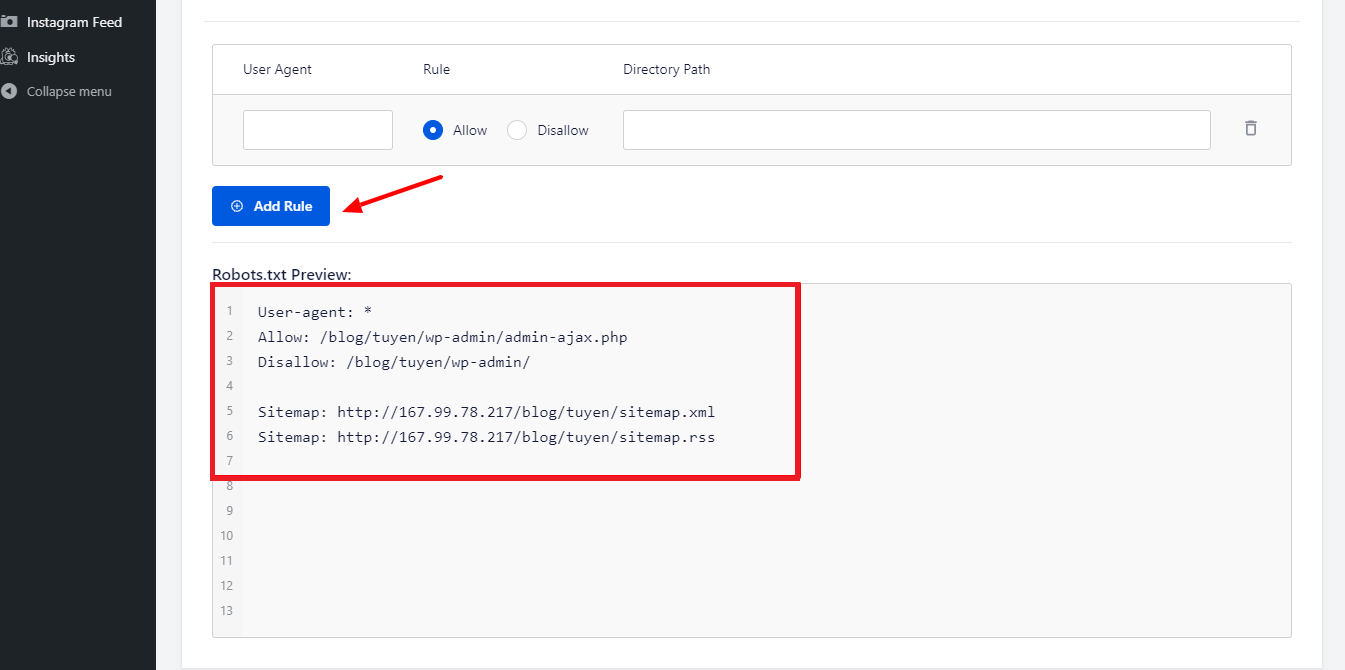

Când derulăm în jos, veți observa că acest plugin afișează o casetă cu o previzualizare a fișierului Robots.txt. Acestea sunt regulile implicite ale WordPress.

Prin selectarea butonului Adăugați regulă , puteți adăuga mai multe reguli specifice pentru a ajuta SEO site-ul dvs.

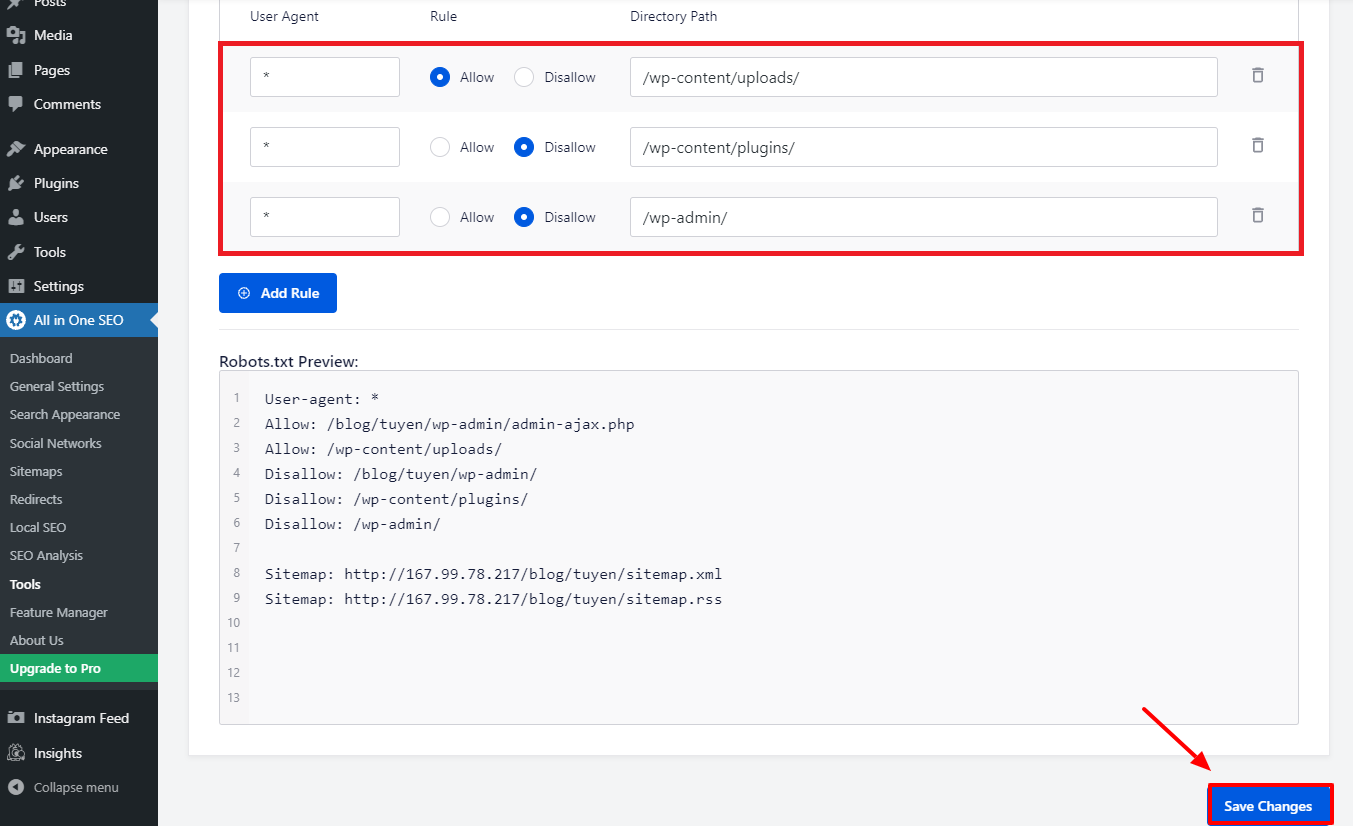

Să introducem un * în câmpul User-Agent pentru a aplica regula tuturor agenților utilizator pentru a adăuga o nouă regulă.

Trebuie doar să selectați Permite sau Dezactivați pentru ca roboții de căutare să se acceseze cu crawlere în etapa următoare.

După aceea, nu uitați să introduceți numele fișierului sau calea directorului în câmpul Calea directorului .

Când ați terminat cu toate preferințele dvs., să apăsăm butonul Salvare modificări .

Toate regulile suplimentare pe care le-ați adăugat deja vor fi aplicate imediat fișierului Robots.txt.

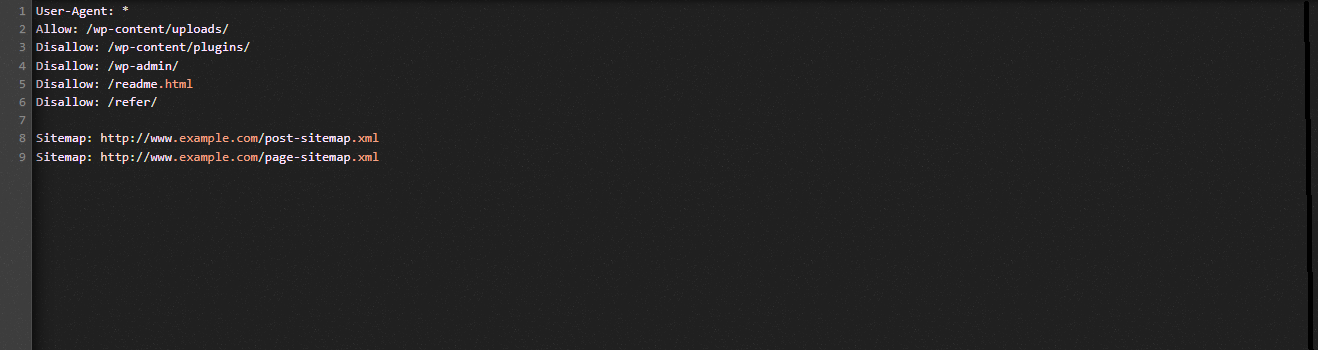

Modificați și optimizați manual WordPress Robots.txt folosind FTP

Aceasta este o abordare diferită a optimizării WordPress Robots.txt de care s-ar putea să vă bucure. Pentru a realiza acest lucru, trebuie să editați fișierul Robots.txt folosind un client FTP.

Pentru a utiliza clientul FPT în mod convenabil, să stabilim mai întâi o conexiune la contul dvs. de găzduire WordPress. Puteți observa cu ușurință fișierul Robots.txt din folderul rădăcină al site-ului dvs. când îl accesați. Să alegem Vizualizare/Editare făcând clic cu butonul din dreapta al mouse-ului.

Pe de altă parte, probabil că nu ai nimic dacă nu îl găsești. Deci, să creăm mai întâi un fișier Robots.txt pentru site-ul dvs., selectând Creați un fișier nou cu butonul din dreapta al mouse-ului.

Fișierul Robots.txt este un fișier text simplu, așa că îl puteți descărca și edita folosind un editor de text simplu precum Notepad sau TextEdit, printre altele. Trebuie pur și simplu să-l încărcați înapoi în folderul rădăcină al site-ului dvs. web după aceea. Pare ușor, nu crezi?

Asigurați-vă că fișierul Robots.txt al site-ului dvs. WordPress funcționează.

Fișierul dvs. Robots.txt trebuie testat după ce l-ați pregătit și configurat, astfel încât orice problemă să poată fi identificată și raportată. Ca rezultat, trebuie să-l testați folosind un instrument de testare Robots.txt. Încercați Google Search Console, deoarece vă recomandăm cu căldură.

Trebuie să vă asigurați că site-ul dvs. web este conectat la Google Search Console dacă doriți să utilizați acest serviciu. Apoi, puteți utiliza Instrumentul de testare roboți selectând proprietatea din lista de selecție. Fișierul Robots.txt pentru site-ul dvs. web va fi acum adăugat automat. Vă va alerta dacă există o greșeală.

Concluzie

În general, obiectivul major al optimizării fișierului Robots.txt este de a opri accesarea roboților de căutare a paginilor care nu sunt necesare publicului larg, inclusiv folderele cu pluginuri sau folderele de administrare. Ca urmare, blocarea etichetelor, categoriilor sau paginilor de arhivă WordPress nu vă va ajuta SEO. Cu alte cuvinte, pentru a crea un fișier Robots.txt perfect pentru site-ul dvs. WordPress, ar trebui să respectați modelul de mai jos.

Sperăm că veți găsi postarea de pe blog astăzi ca fiind utilă pentru optimizarea WordPress Robots.txt. Nu uitați să-l transmiteți cunoscuților și altor webmasteri. De asemenea, vă rugăm să lăsați o remarcă mai jos dacă aveți întrebări. Astfel, vă vom răspunde cât mai curând posibil. Este timpul să optimizați WordPress Robots.txt. Până la viitoarele bloguri, aveți grijă.

Apropo, avem o mulțime de teme WordPress contemporane, atrăgătoare și gratuite, care acceptă pe deplin această funcție utilă. Haideți să-i vedem și să-i cerem unuia dintre ei să vă reproiecteze site-ul