WordPress Robots.txt を簡単に最適化する方法は?

公開: 2023-02-28序章

Web サイトの SEO を向上させるテクニックは数多くあります。 WordPress の Robots.txt を最適化することは、最良の方法の 1 つです。 検索エンジンが Web サイトをスキャンできるようにするため、Robots.txt ファイルは強力な SEO ツールとしてよく知られています。 その結果、Robots.txt ファイルを微調整することで、サイトの SEO を自由に改善できます。 今日のこのブログ投稿で、このトピックに関する WordPress Robots.txt を最適化するためのいくつかのアプローチを明確に紹介します。

Robots.txt ファイルの定義

以下は、WordPress の Robots.txt ファイルの概要です。

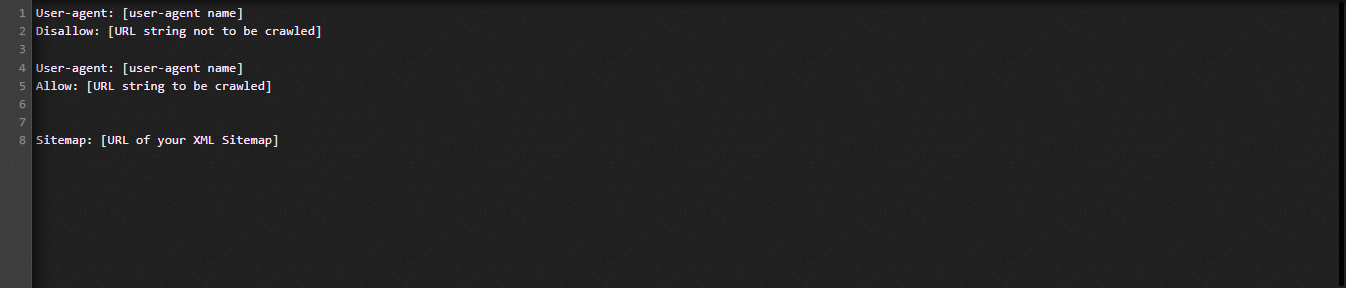

それでは、Robot.txt ファイルの基本構造を見てみましょう。

Robots.txt ファイルで使用される用語を定義しましょう。

- ユーザーエージェント: クローラーの名前

- 許可しない: Web サイトのページ、フォルダー、またはファイルがクロールされないようにします。

- 許可: ディレクトリ、ファイル、およびページのクロールの有効化

- サイトマップ (提供されている場合): サイトマップの場所を表示します: 数字または文字を表します。

- *: 数字または文字の略

- $: 特定の拡張子を含む Web ページを行末まで制限するために使用できます。

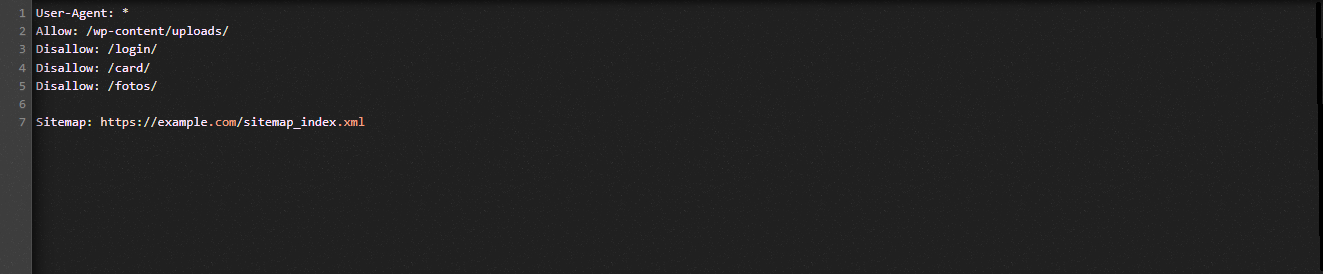

理解を助けるために、次の図を見てみましょう。

Robot.txt の例では、検索エンジンが WordPress アップロード フォルダー内のファイルをクロールすることを許可しています。

ただし、検索エンジンによるログイン、カード、写真フォルダへのアクセスは制限されています。

最後に、サイトマップの URL を提供します。

WordPress Web サイト用に Robots.txt ファイルを作成する必要があるのはなぜですか?

Robots.txt ファイルがなくても、検索エンジンは Web サイトのすべてのページをクロールしてインデックスに登録します。 それでも、指定したフォルダーやページだけでなく、Web サイト上のすべての素材をクロールします。

Web サイト用に Robots.txt ファイルを作成する必要がある主な理由は 2 つあります。 まず第一に、ウェブサイト上のすべての情報を簡単に管理できます。 ページやディレクトリをクロールするか、インデックスを作成するかは、あなた次第です。 これは、プラグイン ファイル、管理ページ、テーマ ディレクトリなどのページが検索エンジンによってクロールされないことを意味します。 その結果、ウェブサイトのインデックスの読み込み速度が向上します。

不要な投稿やページが検索エンジンによってインデックスに登録されないようにする必要があることは、もう 1 つの理由です。 したがって、WordPress のページや投稿が検索結果に表示されないようにするのは簡単かつ便利です。

WordPress Robots.txt をより効率的に最適化する方法

この教育ブログでは、2 つの異なる方法を使用して、WordPress Web サイトの Robots.txt ファイルを作成および改善する方法を紹介します。

- プラグインを使用して Robots.txt ファイルに変更を加える: All in One SEO

- FTP を使用して Robots.txt ファイルを手動で編集する

Robots.txt ファイルをより効果的にするには、All in One SEO プラグインを使用します。

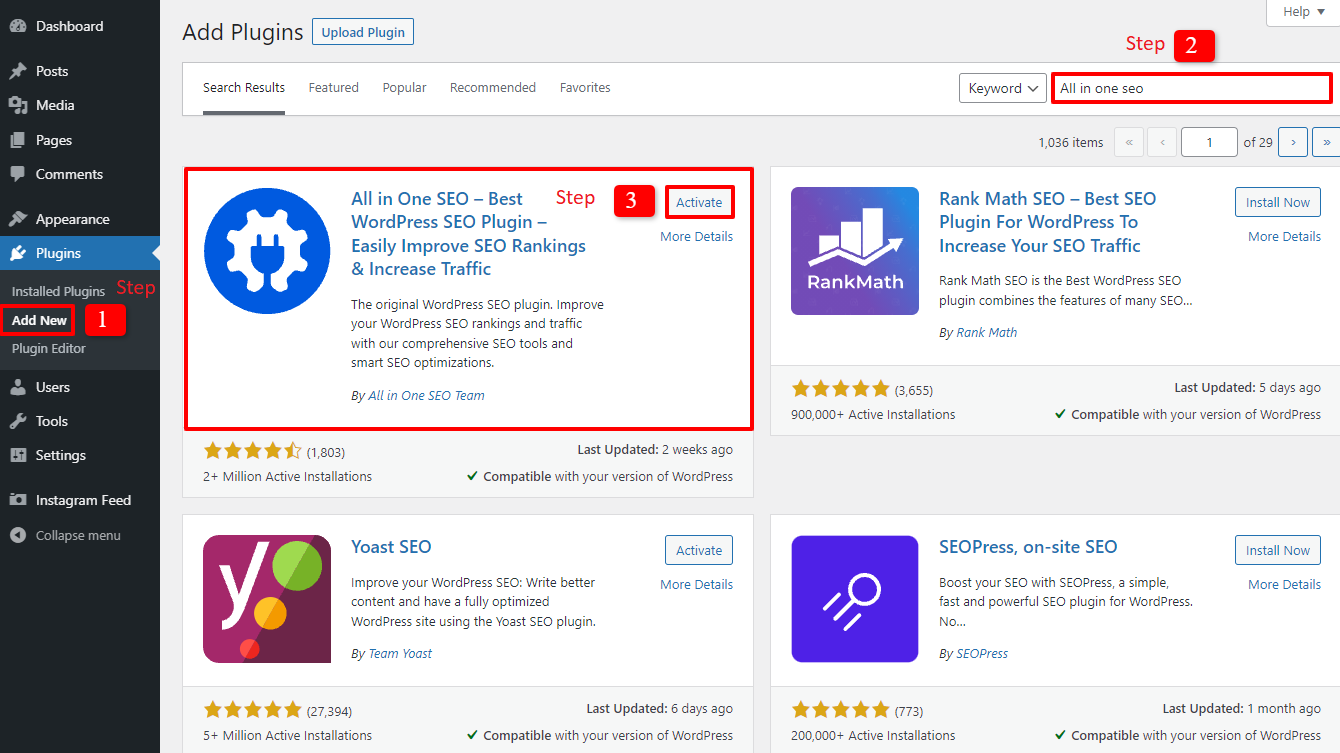

WordPress 市場でのこの問題を解決するために、いくつかの WordPress SEO プラグインが利用可能です。 しかし、この記事では、200 万人以上のユーザーに愛されているプラグインである All in One SEO を採用することにしました。

Plugins -> Add Newを選択して、最初にインストールしましょう。 次に、プラグインの名前を探してインストールし、有効化します。

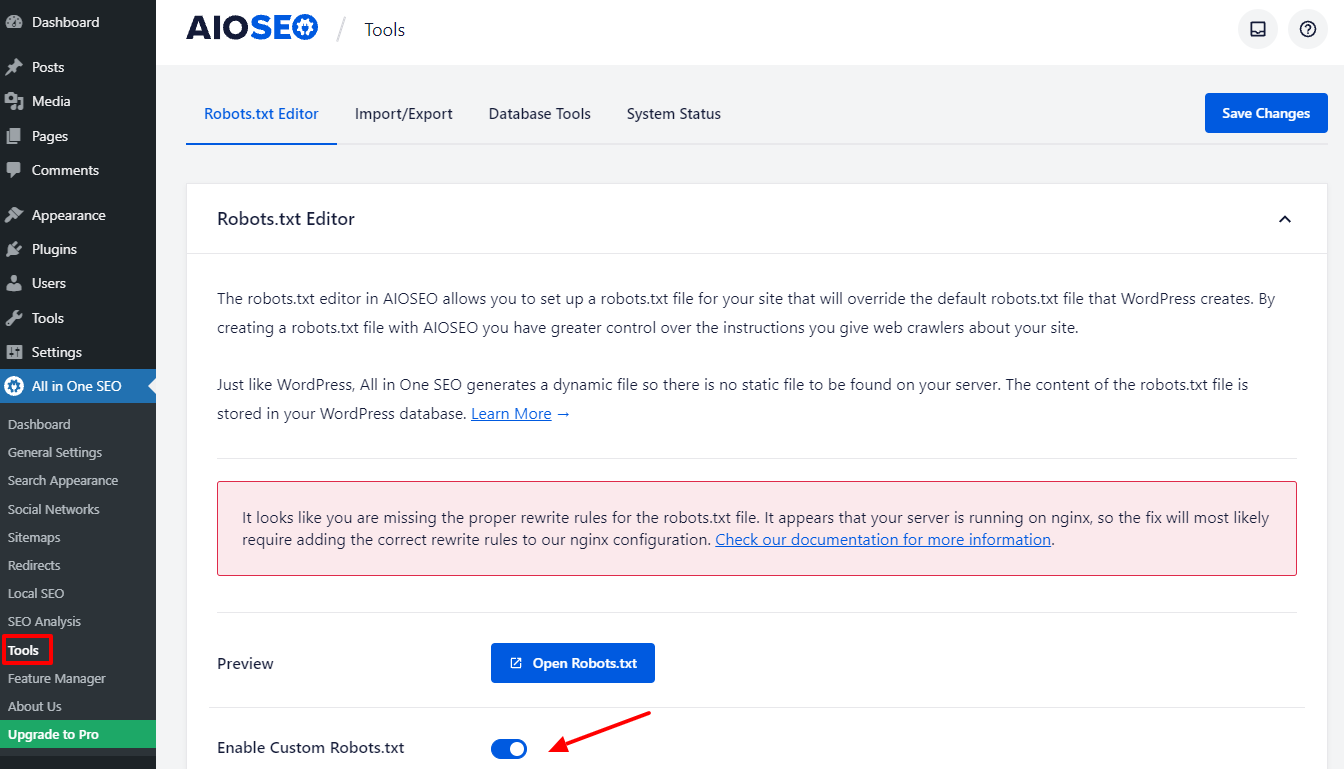

いくつかの簡単な手順を完了すると、管理ダッシュボードに戻ります。 All in one SEO -> Toolsに今すぐ移動します。

Robots.txt Editor セクションのEnable Custome Robots.txtボタンを切り替えてアクティブにします。 オンにすると、WordPress でデフォルトの Robots.txt ファイルを編集できます。

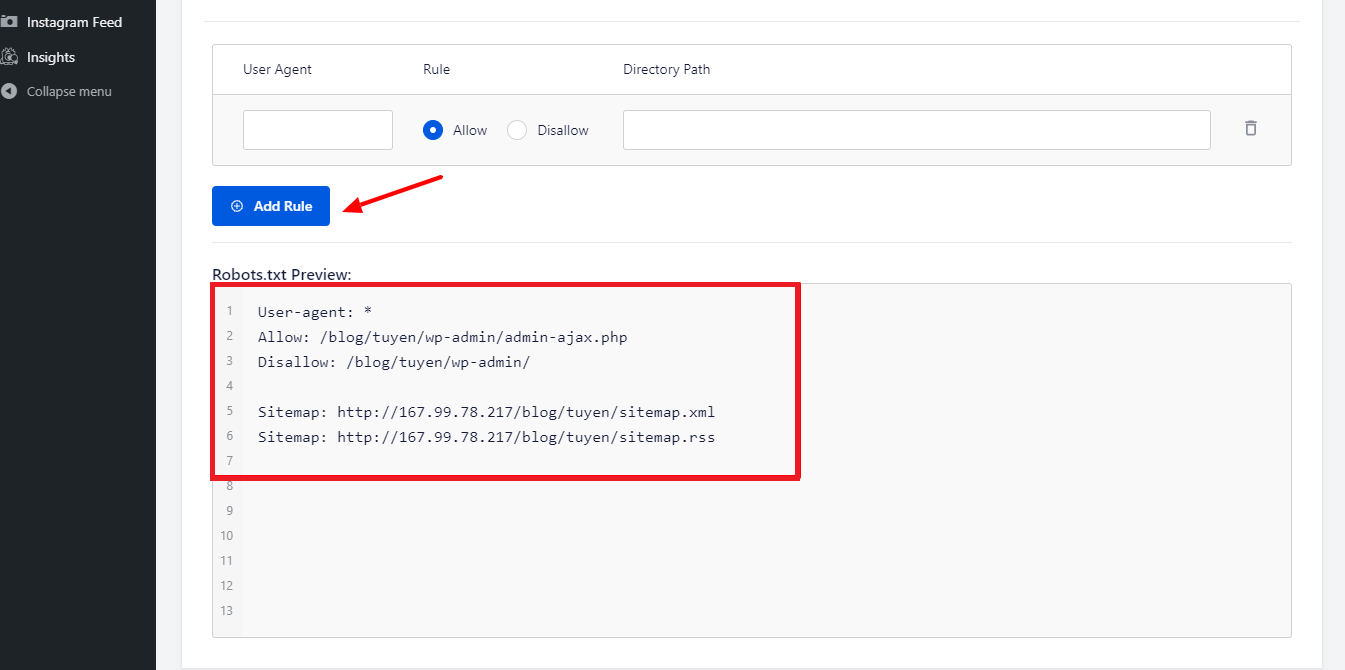

下にスクロールすると、このプラグインのボックスに Robots.txt ファイルのプレビューが表示されます。 これらは WordPress のデフォルトのルールです。

[ルールの追加]ボタンを選択すると、Web サイトの SEO に役立つ独自の特定のルールをさらに追加できます。

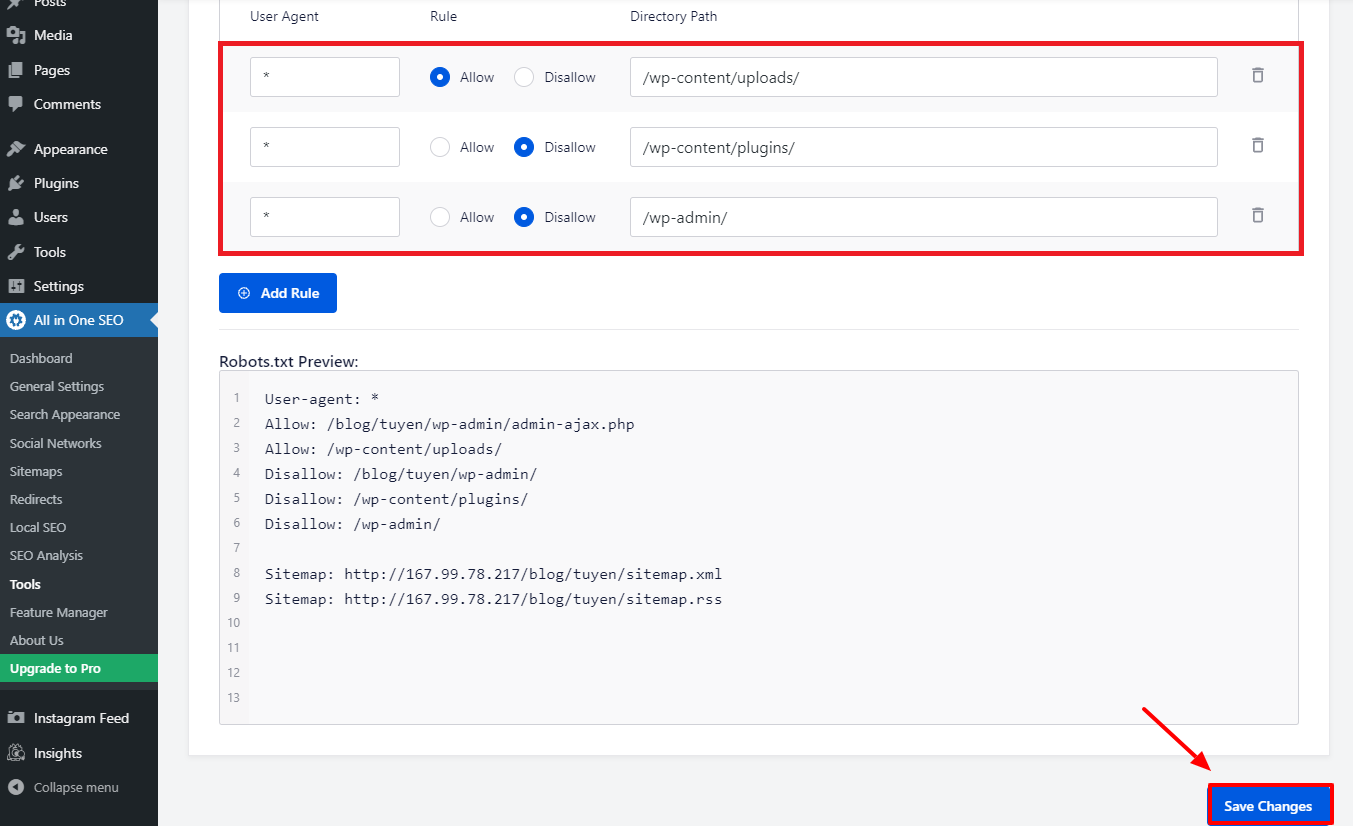

User-Agentフィールドに * を入力して、すべてのユーザー エージェントにルールを適用し、新しいルールを追加します。

次の段階で、検索ボットがクロールすることを許可または禁止するだけを選択する必要があります。

その後、 [ディレクトリ パス]フィールドにファイル名またはディレクトリ パスを入力することを忘れないでください。

すべての設定が完了したら、 [変更を保存]ボタンを押しましょう。

既に追加したすべての追加ルールがすぐに Robots.txt ファイルに適用されます。

FTP を使用して WordPress Robots.txt を手動で変更および最適化する

これは、WordPress の Robots.txt 最適化の別のアプローチです。 これを行うには、FTP クライアントを使用して Robots.txt ファイルを編集する必要があります。

FPT クライアントを便利に利用するために、まず WordPress ホスティング アカウントへの接続を確立しましょう。 アクセスすると、サイトのルート フォルダーにある Robots.txt ファイルに簡単に気付くことができます。 マウスの右ボタンをクリックして、View/Edit を選択しましょう。

逆に、見つからなければ何も持っていない可能性があります。 まず、マウスの右ボタンで [Create a new file] を選択して、Web サイト用の Robots.txt ファイルを作成しましょう。

Robots.txt ファイルはプレーン テキスト ファイルであるため、ダウンロードしてメモ帳や TextEdit などのプレーン テキスト エディタを使用して編集できます。 その後、ウェブサイトのルート フォルダにアップロードするだけです。 簡単そうですよね?

WordPress サイトの Robots.txt ファイルが機能していることを確認します。

問題を特定して報告できるように、準備と構成が完了したら、Robots.txt ファイルをテストする必要があります。 そのため、Robots.txt テスター ツールを使用してテストする必要があります。 強くお勧めする Google Search Console をお試しください。

このサービスを使用する場合は、ウェブサイトが Google Search Console にリンクされていることを確認する必要があります。 次に、選択リストからプロパティを選択して、ロボット テスト ツールを使用できます。 Web サイトの Robots.txt ファイルが自動的に追加されます。 間違いがあれば警告してくれます。

結論

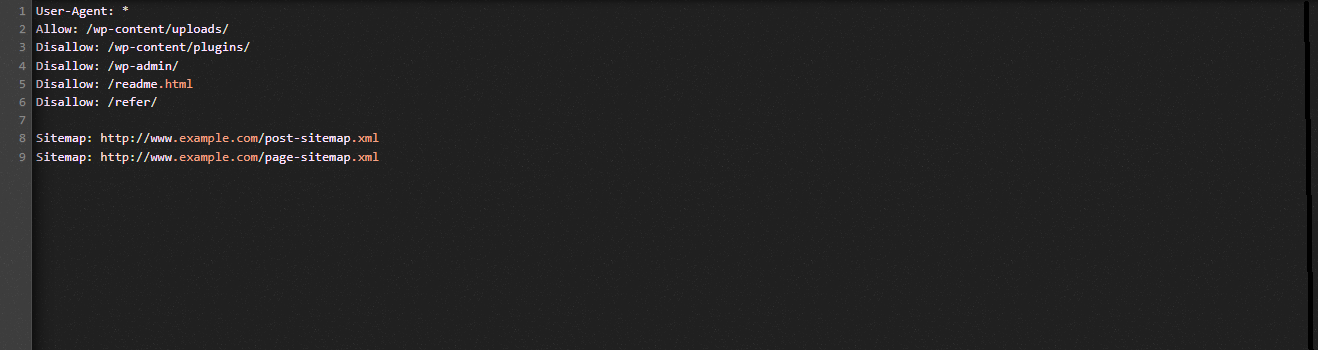

全体として、Robots.txt ファイルを最適化する主な目的は、検索ボットがプラグイン フォルダーや管理フォルダーなど、一般に必要とされていないページにアクセスできないようにすることです。 その結果、WordPress のタグ、カテゴリ、またはアーカイブ ページをブロックしても、SEO には役立ちません。 つまり、WordPress サイトに最適な Robots.txt ファイルを作成するには、以下のパターンに従う必要があります。

本日のブログ投稿が WordPress Robots.txt の最適化に役立つことを願っています。 知人や他のウェブマスターに転送することを忘れないでください. また、ご不明な点がございましたら、以下にコメントを残してください。 そのため、可能な限り迅速に対応いたします。 WordPress Robots.txt を最適化する時が来ました。 今後のブログまで、お気をつけて。

ちなみに、この便利な機能を完全にサポートする現代的で魅力的な無料の WordPress テーマがたくさんあります。 彼らに会いに行って、あなたのウェブサイトの再設計を依頼しましょう