14 Errori Comuni di WordPress Robots.txt da Evitare

Pubblicato: 2025-01-14Robots.txt è un potente file server che indica ai crawler di ricerca e ad altri bot come comportarsi sul tuo sito Web WordPress. Può influenzare notevolmente l'ottimizzazione dei motori di ricerca (SEO) del tuo sito, sia positivamente che negativamente.

Per questo motivo, dovresti sapere cos'è questo file e come usarlo. Altrimenti potresti danneggiare il tuo sito web o, almeno, lasciare sul tavolo parte del suo potenziale.

Per aiutarti a evitare questo scenario, in questo post tratteremo in dettaglio il file robots.txt. Definiremo di cosa si tratta, il suo scopo, come trovare e gestire il tuo file e cosa dovrebbe contenere. Successivamente, esamineremo gli errori più comuni che le persone commettono con il file robots.txt di WordPress, i modi per evitarli e come rimediare se scopri di aver commesso un errore.

Cos'è il file robots.txt di WordPress?

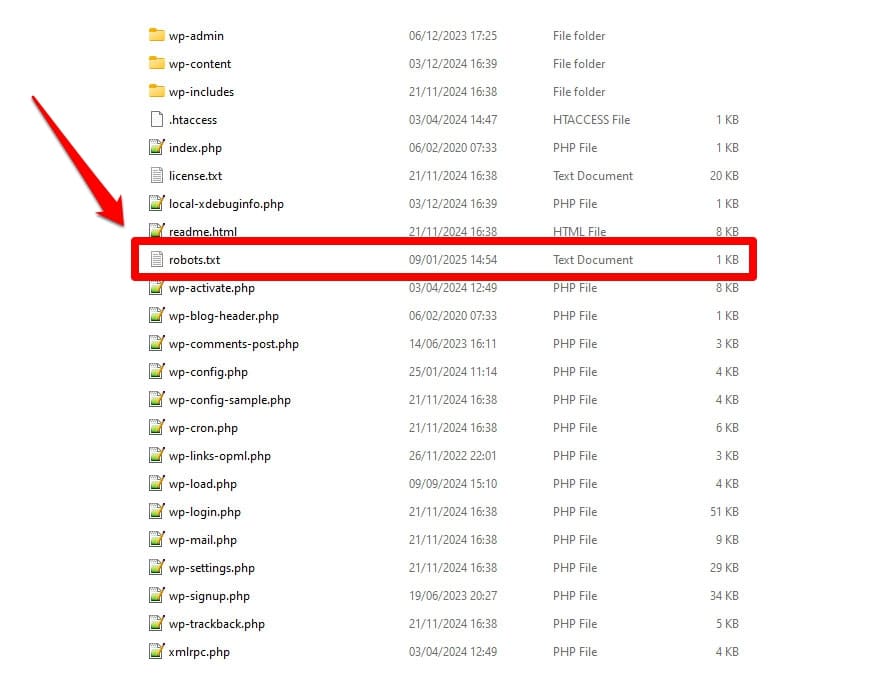

Come accennato, robots.txt è un file di configurazione del server. Di solito lo trovi nella cartella principale del tuo server.

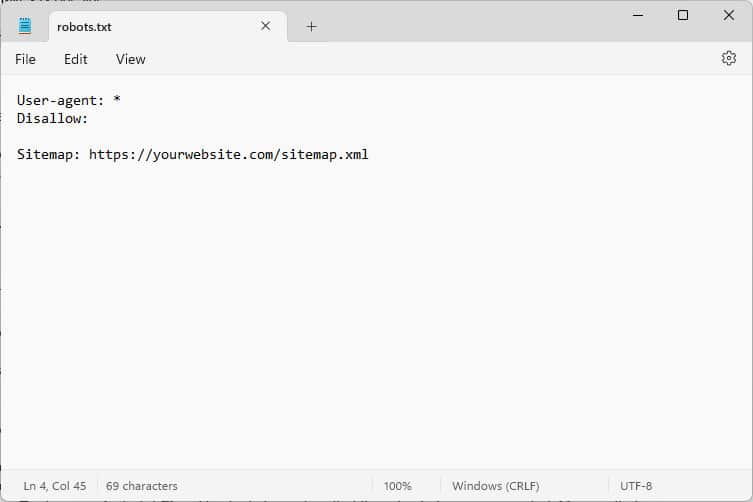

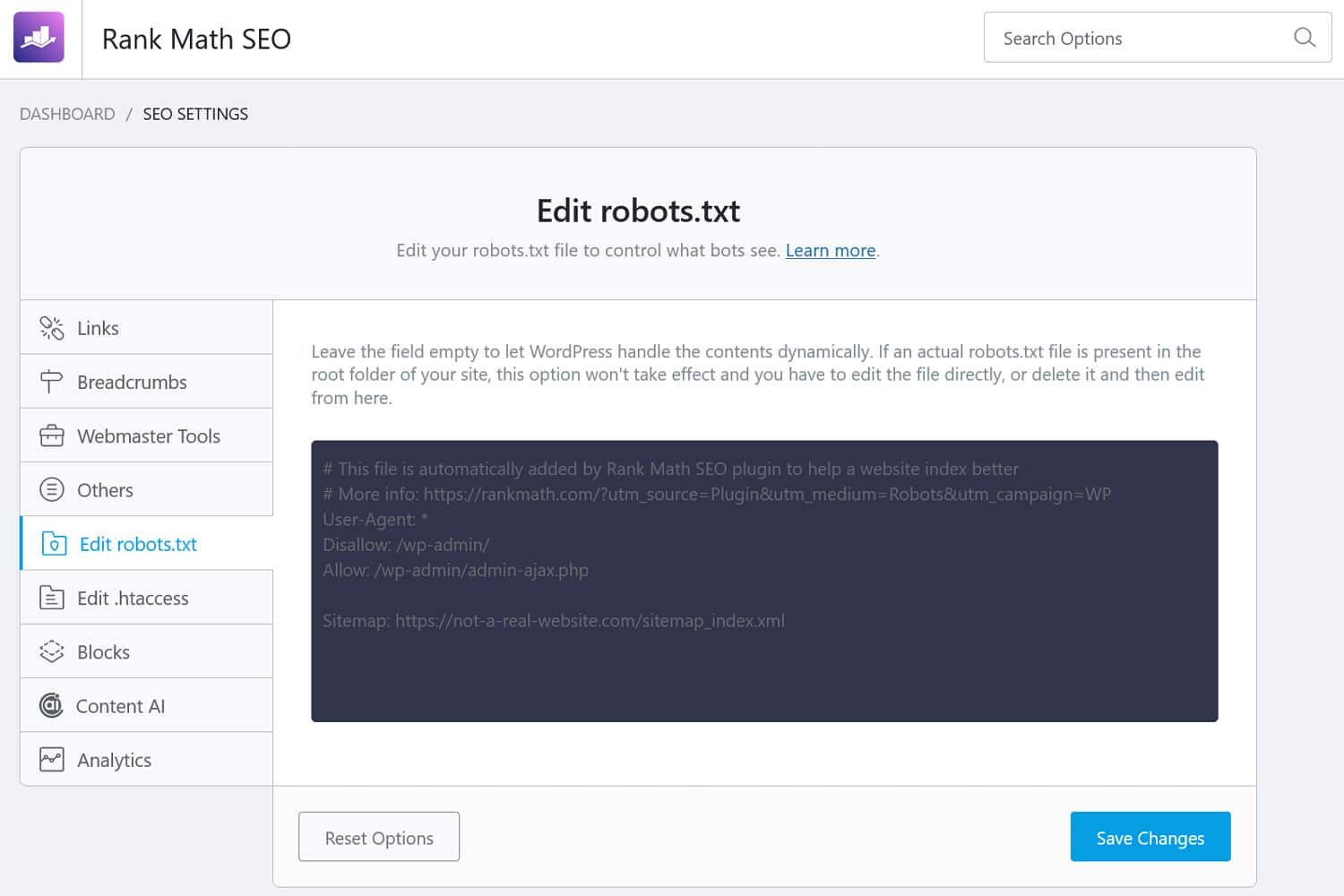

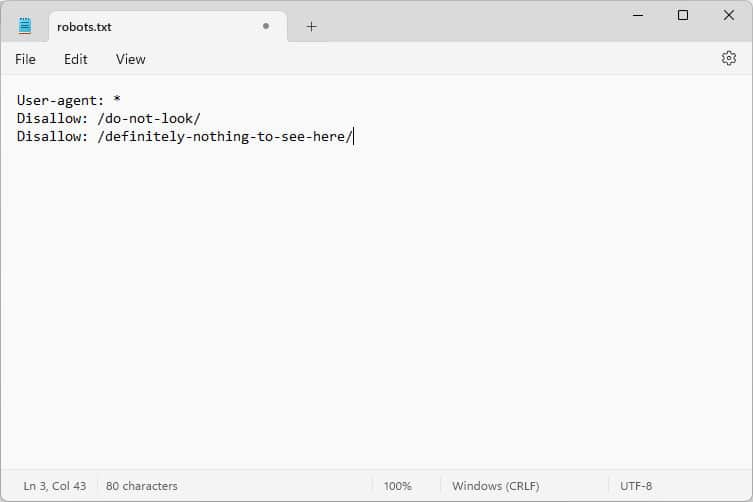

Quando lo apri, il contenuto assomiglia a questo:

Questi pezzi di codice sono istruzioni che dicono ai bot che arrivano sul tuo sito web come comportarsi mentre sono lì, in particolare, a quali parti del tuo sito web accedere e a quali no.

Quali robot, chiedi?

Gli esempi più comuni sono i crawler automatici dei motori di ricerca alla ricerca di pagine web da indicizzare o aggiornare, ma anche i bot di modelli AI e altri strumenti automatizzati.

Quali direttive puoi dare con questo file?

Robots.txt conosce fondamentalmente quattro direttive chiave:

- User-agent : definisce a chi, ovvero a quale gruppo o singoli bot sono rivolte le regole che seguono.

- Disallow : indica le directory, i file o le risorse a cui è vietato l'accesso all'agente utente.

- Consenti : può essere utilizzato per impostare eccezioni, ad esempio per consentire l'accesso a singole cartelle o risorse in directory altrimenti vietate.

- Mappa del sito : indirizza i bot alla posizione dell'URL della mappa del sito di un sito web.

Solo User-agent e Disallow sono obbligatori affinché il file svolga il proprio lavoro; le altre due direttive sono facoltative. Ad esempio, ecco come impedire a qualsiasi bot di accedere al tuo sito:

User-agent: * Disallow: /L'asterisco indica che la seguente regola si applica a tutti gli interpreti. La barra dopo Disallow indica che tutte le directory di questo sito sono vietate. Questo è il file robots.txt che trovi solitamente sui siti di sviluppo, che non dovrebbero essere indicizzati dai motori di ricerca.

Tuttavia, puoi anche impostare regole per singoli bot:

User-agent: Googlebot Allow: /private/resources/È importante notare che robots.txt non è vincolante. Solo i robot delle organizzazioni che aderiscono al Robots Exclusion Protocol obbediranno alle sue indicazioni. I bot dannosi, come quelli che cercano falle di sicurezza nel tuo sito, possono ignorarli e li ignoreranno, ed è necessario adottare misure aggiuntive contro di loro.

Anche le organizzazioni che aderiscono allo standard ignoreranno alcune direttive. Ne parleremo di esempi più avanti.

Perché il file robots.txt è importante?

Non è obbligatorio che il tuo sito WordPress abbia un file robots.txt. Il tuo sito funzionerà senza uno e i motori di ricerca non ti penalizzeranno per non averlo. Tuttavia, includerne uno ti consente di:

- Mantieni i contenuti fuori dai risultati di ricerca, come le pagine di accesso o determinati file multimediali.

- Impedisci ai crawler di ricerca di sprecare il tuo budget di scansione su parti non importanti del tuo sito, ignorando eventualmente le pagine che desideri che indicizzino.

- Indirizza i motori di ricerca alla tua mappa del sito in modo che possano esplorare più facilmente il resto del tuo sito web.

- Preserva le risorse del server tenendo lontani i bot inutili.

Tutto ciò aiuta a migliorare il tuo sito, in particolare il tuo SEO, motivo per cui è importante che tu capisca come utilizzare robots.txt.

Come trovare, modificare e creare il file robots.txt di WordPress

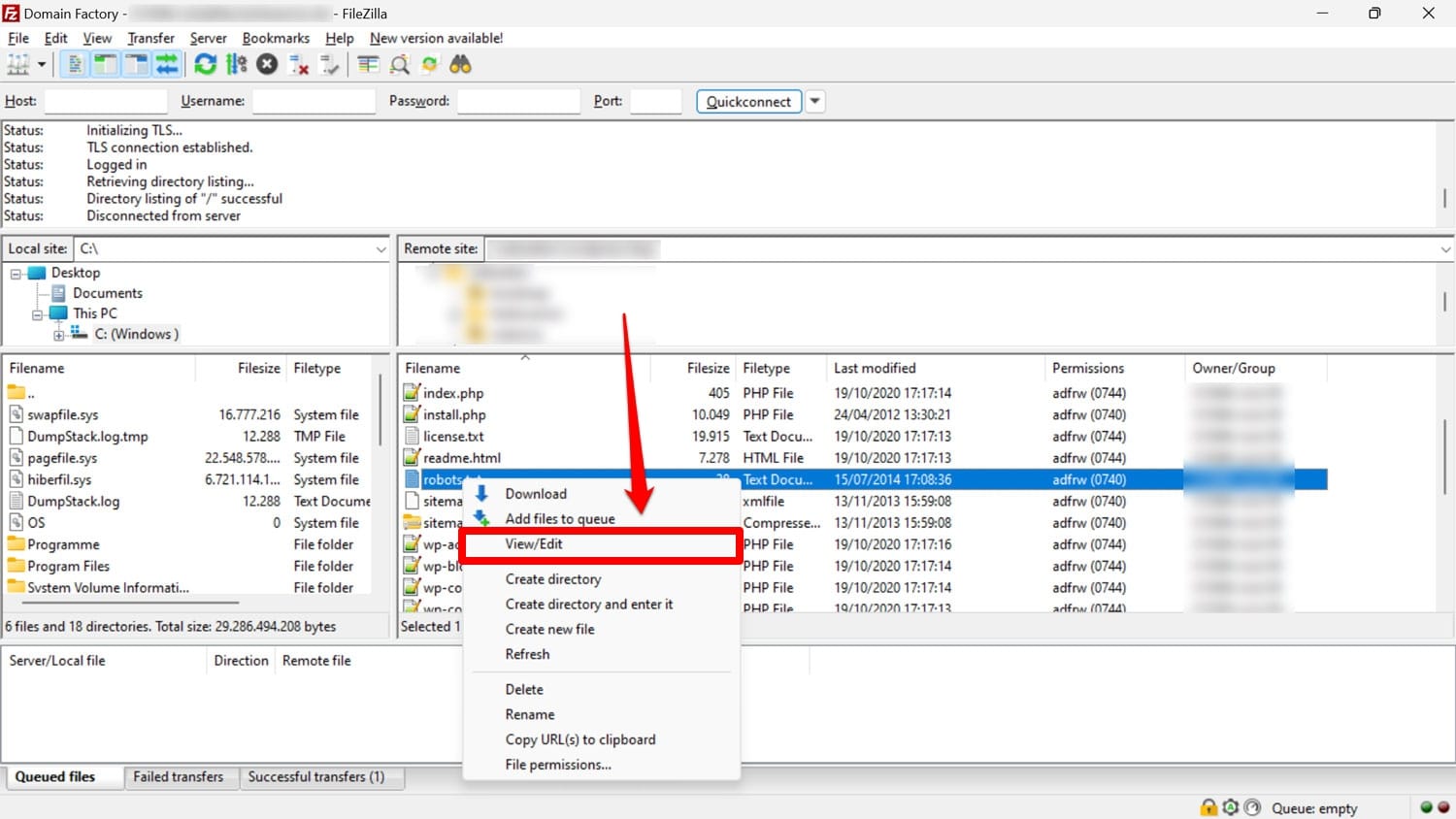

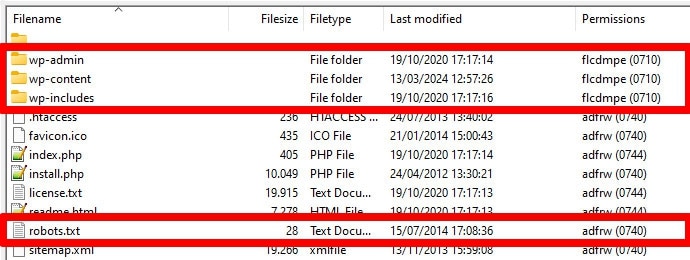

Come accennato, robots.txt di solito si trova nella cartella principale del tuo sito web sul server. Puoi accedervi da lì con un client FTP come FileZilla e modificarlo con qualsiasi editor di testo.

Se non ne hai uno, è possibile creare semplicemente un file di testo vuoto, chiamarlo "robots.txt", riempirlo con le direttive e caricarlo.

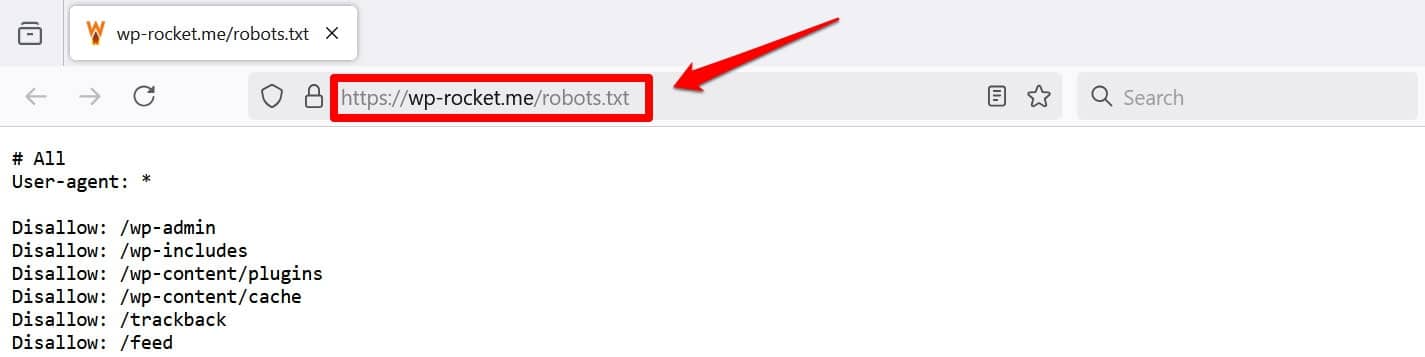

Un altro modo per visualizzare almeno il tuo file è aggiungere /robots.txt al tuo dominio, ad esempio https://wp-rocket.me/robots.txt.

Inoltre, ci sono modi per accedere al file dal back-end di WordPress. Molti plugin SEO ti consentono di vederlo e spesso di apportarvi modifiche dall'interfaccia di amministrazione.

In alternativa, puoi anche utilizzare un plugin come WPCode.

Che aspetto ha un buon file robots.txt di WordPress?

Non esiste una risposta valida per tutti su quali direttive dovrebbero essere presenti nel file del tuo sito web; dipende dalla tua configurazione. Ecco un esempio che ha senso per molti siti Web WordPress:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlQuesto esempio ottiene diversi risultati:

- Blocca l'accesso all'area di amministrazione

- Consente l'accesso alle funzionalità di amministrazione essenziali

- Fornisce una posizione sulla mappa del sito

Questa configurazione raggiunge un equilibrio tra sicurezza, prestazioni SEO e scansione efficiente.

Non Commettere Questi 14 Errori nel file robots.txt di WordPress

Se il tuo obiettivo è impostare e ottimizzare il file robots.txt per il tuo sito, assicurati di evitare i seguenti errori.

1. Ignorare il file robots.txt interno di WordPress

Anche se non hai un file robots.txt “fisico” nella directory principale del tuo sito, WordPress viene fornito con il proprio file virtuale. Questo è particolarmente importante da ricordare se scopri che i motori di ricerca non indicizzano il tuo sito web.

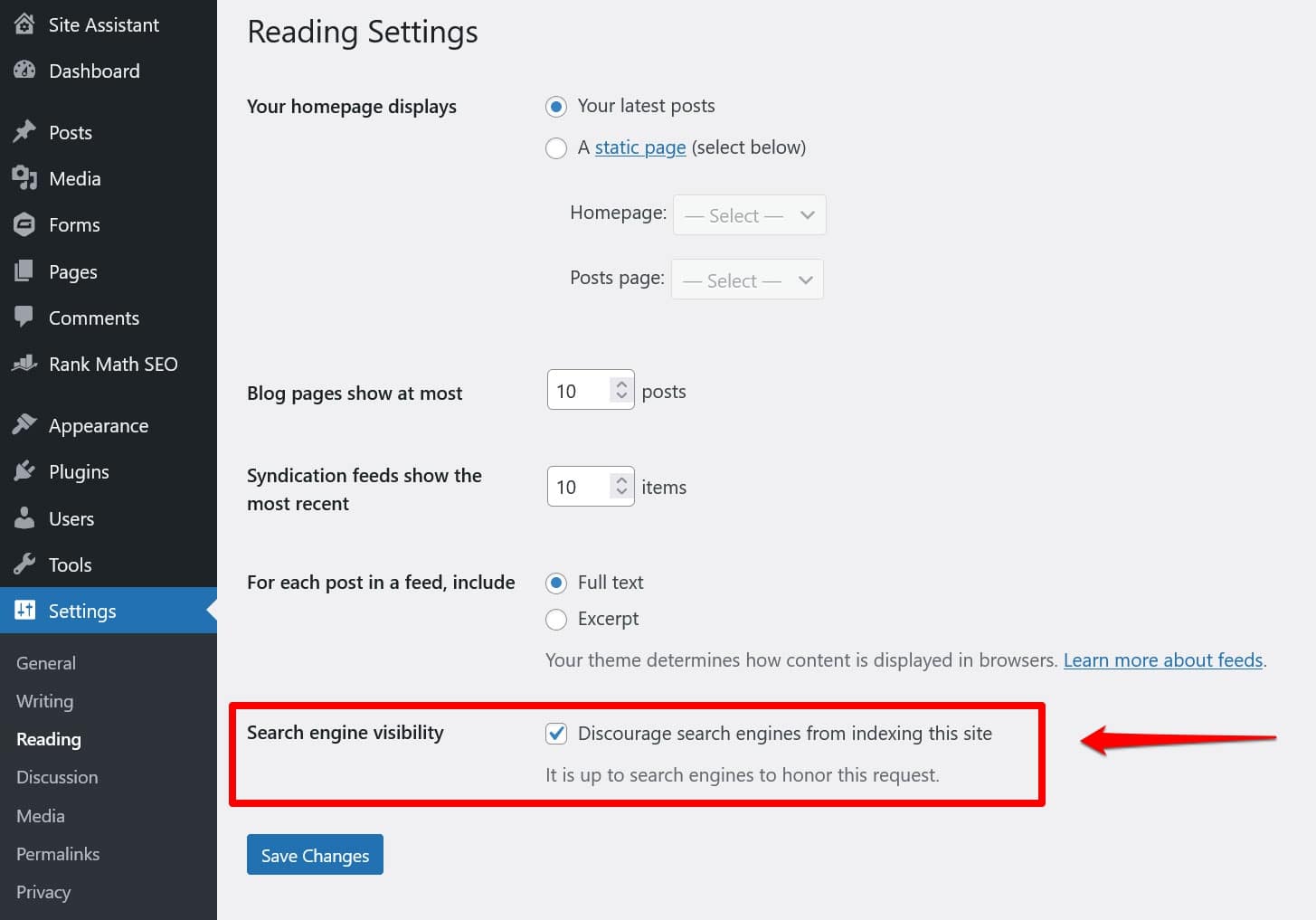

In tal caso, ci sono buone probabilità che tu abbia abilitato l'opzione per scoraggiarli dal farlo in Impostazioni > Lettura .

Questo inserisce una direttiva per tenere fuori tutti i crawler di ricerca nel robots.txt virtuale. Per disabilitarlo deseleziona la casella e salvala in basso.

2. Posizionarlo nella posizione sbagliata

I bot, in particolare i crawler di ricerca, cercano il file robots.txt solo in una posizione: la directory principale del tuo sito web. Se lo inserisci altrove, ad esempio in una cartella, non lo troveranno e lo ignoreranno.

La tua directory root dovrebbe essere la posizione in cui ti trovi quando accedi al tuo server tramite FTP, a meno che tu non abbia inserito WordPress in una sottodirectory. Se vedi le cartelle wp-admin , wp-content e wp-includes , sei nel posto giusto.

3. Incluso markup obsoleto

Oltre alle direttive sopra menzionate, ce ne sono altre due che potresti ancora trovare nei file robots.txt dei siti web più vecchi:

- Noindex – Utilizzato per specificare gli URL che i motori di ricerca non dovrebbero indicizzare sul tuo sito.

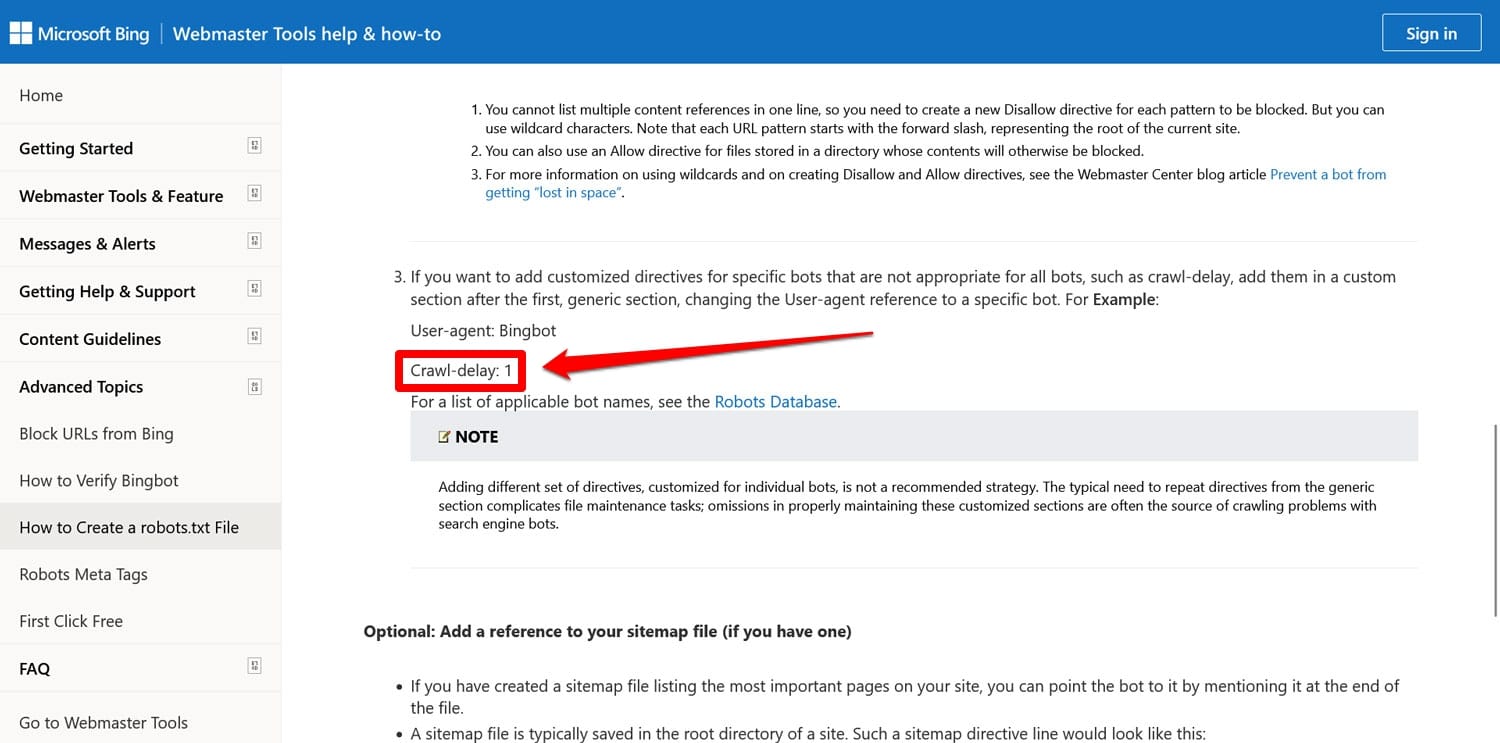

- Crawl-delay : una direttiva intesa a limitare i crawler in modo che non sovraccarichino le risorse del server web.

Entrambe queste direttive sono ora ignorate, almeno da Google. Bing, almeno, onora ancora il ritardo della scansione.

Nella maggior parte dei casi è meglio non utilizzare queste direttive. Ciò aiuta a mantenere il file snello e riduce il rischio di errori.

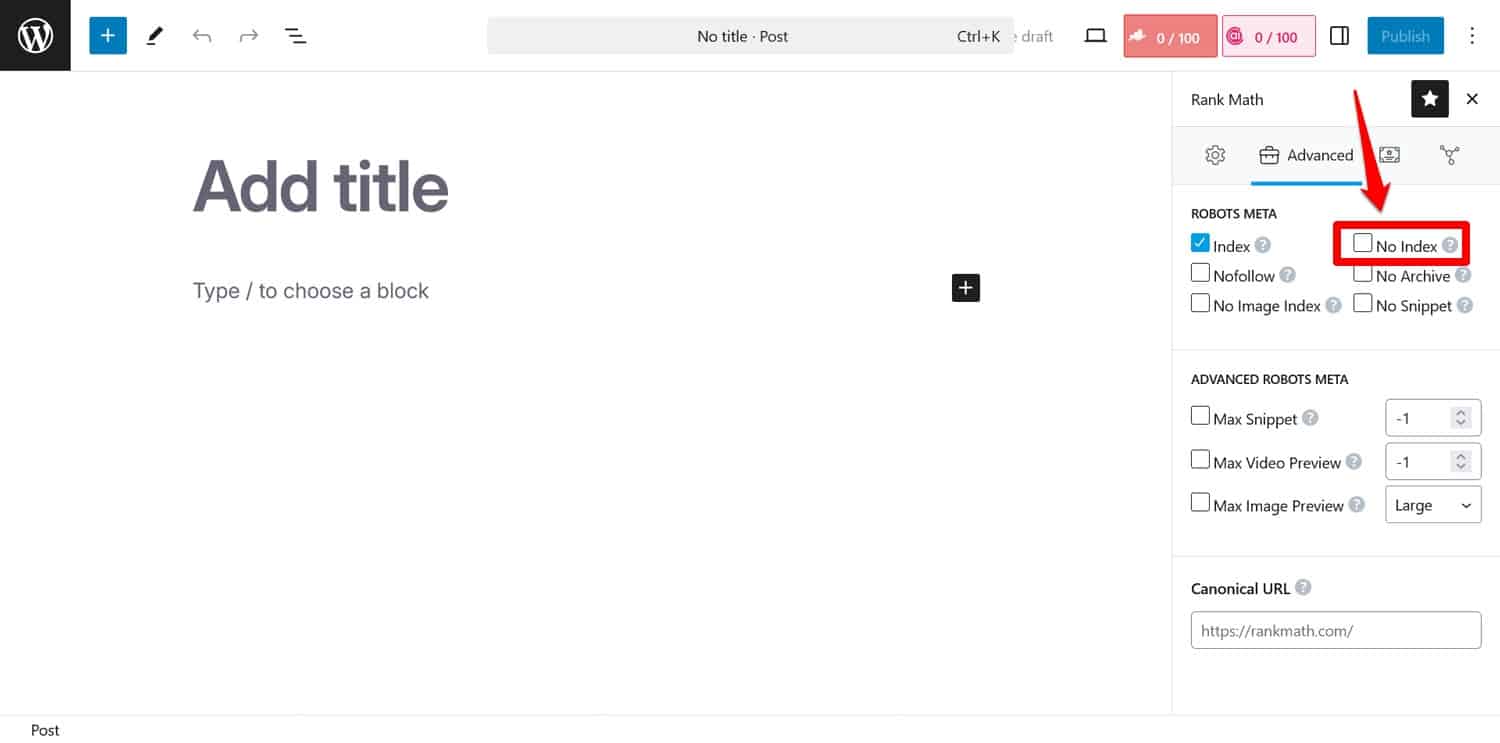

Suggerimento: se il tuo obiettivo è impedire ai motori di ricerca di indicizzare determinate pagine, utilizza invece il meta tag noindex . Puoi implementarlo con un plugin SEO per pagina.

Se blocchi le pagine tramite robots.txt, i crawler non arriveranno alla parte in cui vedono il tag noindex . In questo modo, potrebbero comunque indicizzare la tua pagina ma senza il suo contenuto, il che è peggio.

4. Blocco delle risorse essenziali

Uno degli errori commessi dalle persone è utilizzare robots.txt per bloccare l'accesso a tutti i fogli di stile (file CSS) e script (file JavaScript) sul proprio sito WordPress per preservare il budget di scansione.

Tuttavia, non è una buona idea. I bot dei motori di ricerca visualizzano le pagine per “vederle” nello stesso modo in cui lo fanno i visitatori. Questo li aiuta a comprendere il contenuto in modo che possano indicizzarlo di conseguenza.

Bloccando queste risorse, potresti dare ai motori di ricerca un'impressione sbagliata delle tue pagine, portandole potenzialmente a non essere indicizzate correttamente o danneggiandone il posizionamento.

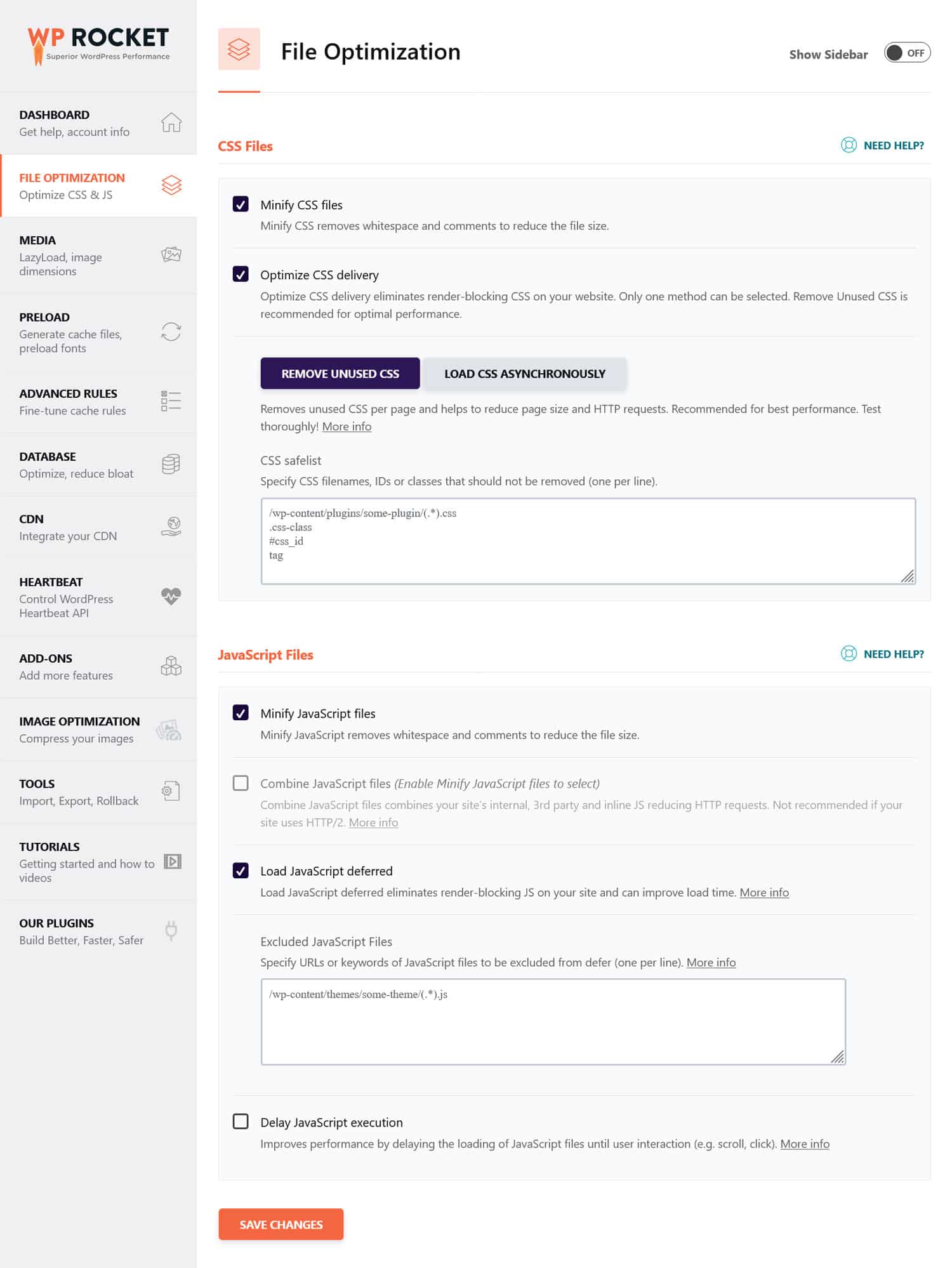

Se ritieni che i file CSS e JavaScript possano ostacolare le prestazioni del tuo sito, è un'idea migliore ottimizzarli per caricarli rapidamente, sia per i bot che per i visitatori abituali. Puoi farlo minimizzando il codice e comprimendo i file del sito web in modo che trasmettano più velocemente. Inoltre, è possibile ottimizzarne la distribuzione eliminando il codice inutilizzato e rinviando le risorse che bloccano il rendering.

Suggerimento : puoi semplificare questo processo utilizzando un plugin per le prestazioni come WP Rocket. La sua interfaccia intuitiva ti consente di ottimizzare la consegna dei file selezionando alcune caselle nel menu Ottimizzazione file .

WP Rocket include anche funzionalità aggiuntive per migliorare le prestazioni del sito Web, tra cui:

- Caching, con una cache mobile dedicata

- Caricamento lento per immagini e video

- Precaricamento di cache, collegamenti, file esterni e caratteri

- Ottimizzazione della banca dati

Inoltre, il plugin implementa automaticamente molti passaggi di ottimizzazione. Gli esempi includono la memorizzazione nella cache del browser e del server, la compressione GZIP e l'ottimizzazione delle immagini sopra la piega per migliorare LCP. In questo modo, il tuo sito diventerà più veloce semplicemente attivando WP Rocket.

Il plugin offre anche una garanzia di rimborso di 14 giorni, così puoi testarlo senza rischi.

5. Impossibile aggiornare il file robots.txt di sviluppo

Quando creano un sito Web, gli sviluppatori in genere includono un file robots.txt che impedisce a tutti i bot di accedervi. Questo ha senso; l'ultima cosa che desideri è che il tuo sito incompleto venga visualizzato nei risultati di ricerca.

Un problema si verifica solo quando trasferisci accidentalmente questo file sul tuo server di produzione e impedisci ai motori di ricerca di indicizzare anche il tuo sito web live. Controlla sicuramente questo se il tuo contenuto si rifiuta di apparire nei risultati di ricerca.

6. Esclusione di un collegamento alla mappa del sito

Il collegamento alla tua mappa del sito da robots.txt fornisce ai crawler dei motori di ricerca un elenco di tutti i tuoi contenuti. Ciò aumenta le possibilità che indicizzino qualcosa di più della semplice pagina corrente su cui sono arrivati.

Tutto ciò che serve è una riga:

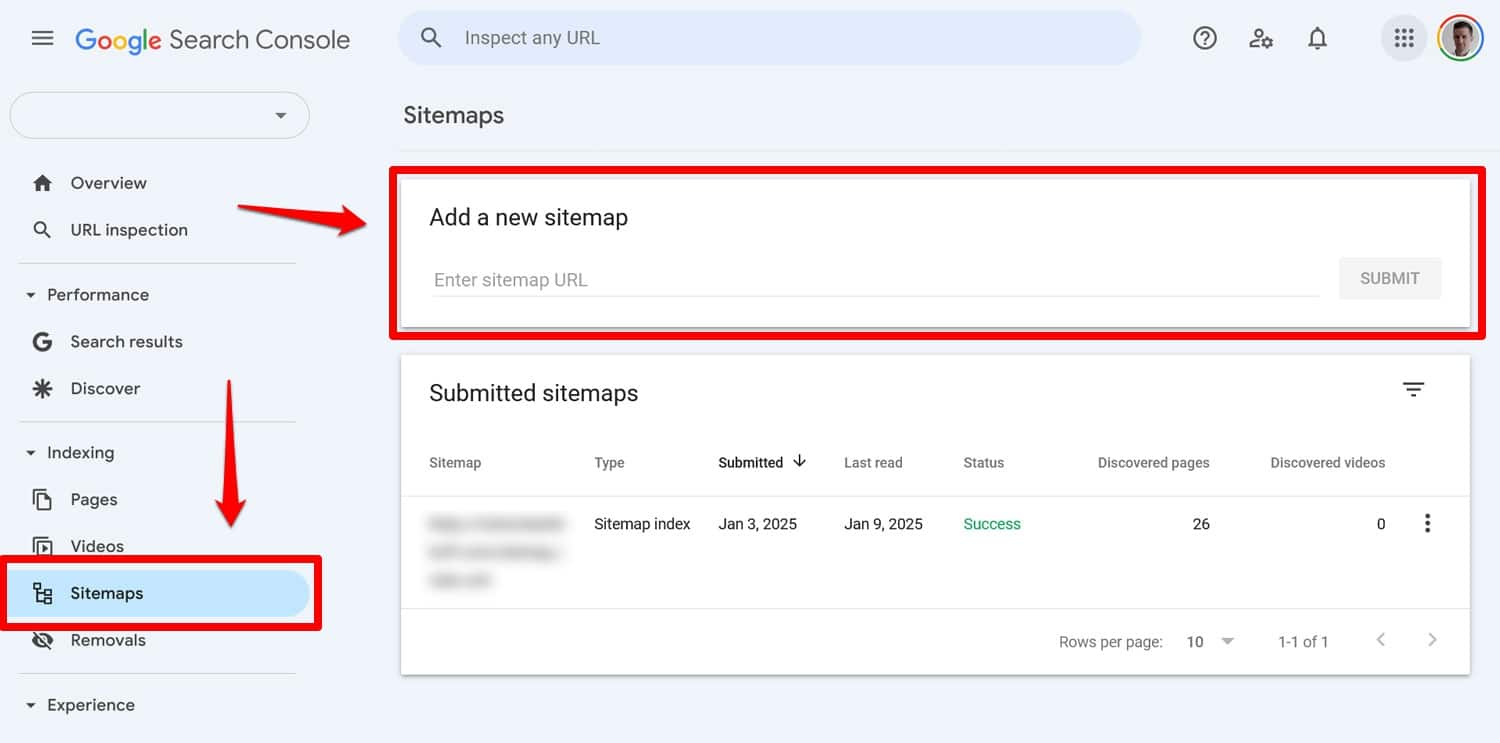

Sitemap: https://yourwebsite.com/sitemap.xmlSì, puoi anche inviare la tua mappa del sito direttamente in strumenti come Google Search Console.

Tuttavia, includerlo nel file robots.txt è comunque utile, soprattutto per i motori di ricerca di cui non utilizzi gli strumenti per i webmaster.

7. Utilizzo di regole contrastanti

Un errore comune nella creazione di un file robots.txt è l'aggiunta di regole che si contraddicono tra loro, come ad esempio:

User-agent: * Disallow: /blog/ Allow: /blog/Le direttive di cui sopra lasciano ai motori di ricerca poco chiaro se debbano eseguire la scansione della directory /blog/ o meno. Ciò porta a risultati imprevedibili e può danneggiare il tuo SEO.

| Sei curioso di sapere cos'altro può essere dannoso per il posizionamento nelle ricerche del tuo sito e come evitarlo? Scoprilo nella nostra guida agli errori SEO. |

Per evitare conflitti, seguire queste best practice:

- Utilizza prima le regole specifiche : posiziona le regole più specifiche prima di quelle più ampie.

- Evita la ridondanza : non includere direttive opposte per lo stesso percorso.

- Testa il tuo file robots.txt : utilizza gli strumenti per verificare che le regole si comportino come previsto. Ne parleremo più avanti.

8. Tentativo di nascondere contenuti sensibili con robots.txt

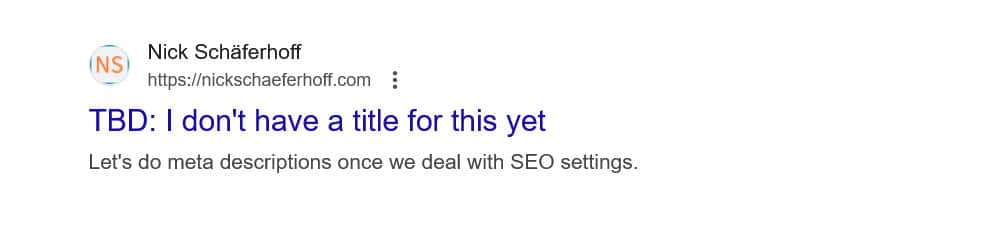

Come accennato in precedenza, robots.txt non è uno strumento per mantenere i contenuti fuori dai risultati di ricerca. Infatti, poiché il file è accessibile pubblicamente, utilizzarlo per bloccare contenuti sensibili potrebbe inavvertitamente rivelare esattamente dove si trovano tali contenuti.

Suggerimento : utilizza il meta tag noindex per mantenere i contenuti fuori dai risultati di ricerca. Inoltre, proteggi con password le aree sensibili del tuo sito per tenerle al sicuro sia dai robot che dagli utenti non autorizzati.

9. Utilizzo improprio dei caratteri jolly

I caratteri jolly ti consentono di includere grandi gruppi di percorsi o file nelle tue direttive. Ne abbiamo già incontrato uno in precedenza, il simbolo *. Significa "ogni istanza di" ed è utilizzato più frequentemente per impostare regole che si applicano a tutti gli user agent.

Un altro simbolo jolly è $, che applica le regole alla parte finale di un URL. Puoi usarlo, ad esempio, se desideri impedire ai crawler di accedere a tutti i file PDF sul tuo sito:

Disallow: /*.pdf$Sebbene i caratteri jolly siano utili, possono avere conseguenze di ampia portata. Usali con attenzione e testa sempre il tuo file robots.txt per assicurarti di non aver commesso errori.

10. Confusione tra URL assoluti e relativi

Ecco la differenza tra URL assoluti e relativi:

- URL assoluto – https://tuositoweb.com/privato/

- URL relativo – /privato/

Ti consigliamo di utilizzare URL relativi nelle direttive robots.txt, ad esempio:

Disallow: /private/Gli URL assoluti possono causare problemi in cui i bot potrebbero ignorare o interpretare erroneamente la direttiva. L'unica eccezione è il percorso della tua mappa del sito, che deve essere un URL assoluto.

11. Ignorare la distinzione tra maiuscole e minuscole

Le direttive Robots.txt fanno distinzione tra maiuscole e minuscole. Ciò significa che le seguenti due direttive non sono intercambiabili:

Disallow: /Private/ Disallow: /private/Se scopri che il tuo file robots.txt non si comporta come previsto, controlla se il problema potrebbe essere dovuto all'errata capitalizzazione.

12. Utilizzo errato delle barre finali

Una barra finale è una barra alla fine di un URL:

- Senza una barra finale : /directory

- Con una barra finale : /directory/

In robots.txt decide quali risorse del sito sono consentite e non consentite. Ecco un esempio:

Disallow: /private/La regola di cui sopra impedisce ai crawler di accedere alla directory "privata" del tuo sito e a tutto ciò che contiene. D'altra parte, diciamo che tralasci la barra finale, in questo modo:

Disallow: /privateIn questo caso, la regola bloccherebbe anche altre istanze che iniziano con "privato" sul tuo sito, come:

- https://tuositoweb.com/privato.html

- https://tuositoweb.com/privateer

Pertanto è importante essere precisi. In caso di dubbi, prova il tuo file.

13. Robots.txt mancante per i sottodomini

Ogni sottodominio del tuo sito web (ad esempio dev.tuositoweb.com) necessita del proprio file robots.txt perché i motori di ricerca li trattano come entità web separate. Senza un file installato, rischi che i crawler indicizzino parti del tuo sito che intendevi tenere nascoste.

Ad esempio, se la tua versione di sviluppo si trova in una cartella denominata "dev" e utilizza un sottodominio, assicurati che disponga di un file robots.txt dedicato per bloccare i crawler di ricerca.

14. Non testare il file robots.txt

Uno degli errori più grandi quando si configura il file robots.txt di WordPress è non riuscire a testarlo, soprattutto dopo aver apportato modifiche.

Come abbiamo visto, anche piccoli errori di sintassi o logica possono causare problemi SEO significativi. Pertanto, testa sempre il tuo file robots.txt.

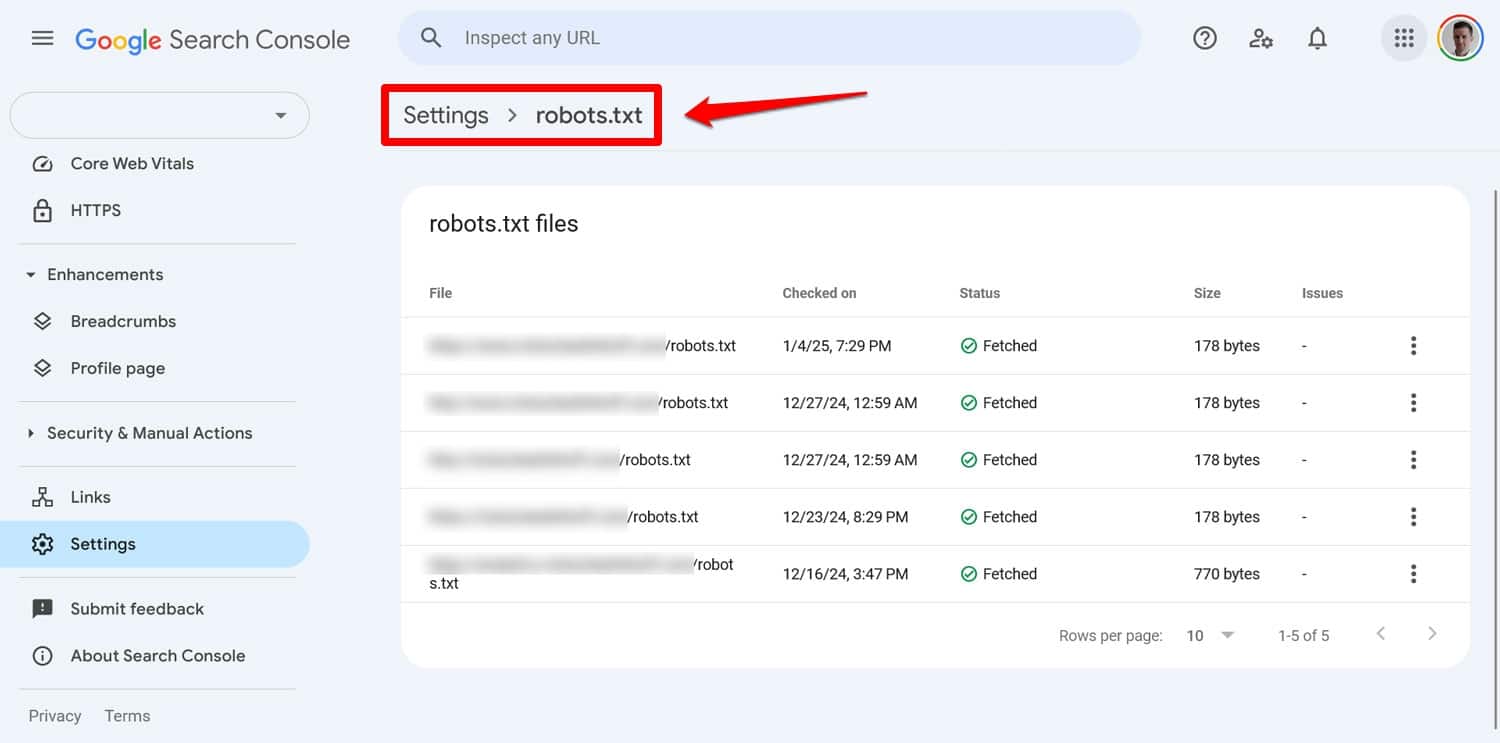

Puoi visualizzare eventuali problemi con il tuo file in Google Search Console in Impostazioni > robots.txt .

Un altro modo è simulare il comportamento di scansione con uno strumento come Screaming Frog. Inoltre, utilizza un ambiente di staging per verificare l'impatto delle nuove regole prima di applicarle al tuo sito live.

Come recuperare da un errore robots.txt

Gli errori nel file robots.txt sono facili da commettere, ma fortunatamente sono anche semplici da correggere una volta scoperti.

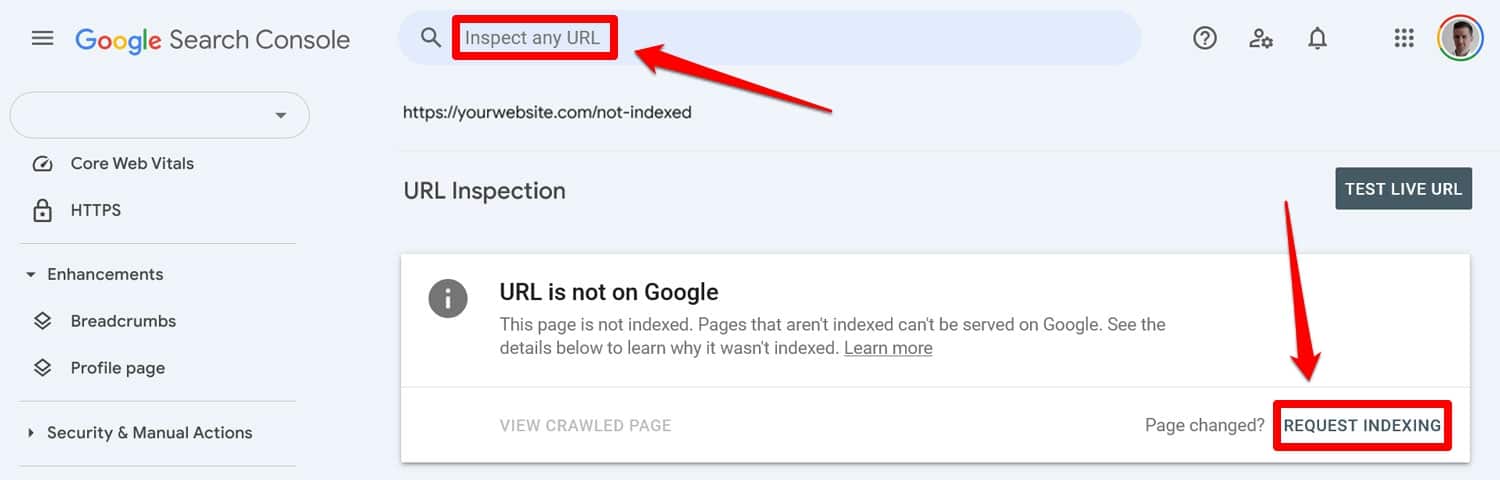

Inizia eseguendo il file robots.txt aggiornato tramite uno strumento di test. Quindi, se le pagine sono state precedentemente bloccate dalle direttive robots.txt, inseriscile manualmente in Google Search Console o Bing Webmaster Tools per richiedere l'indicizzazione.

Inoltre, invia nuovamente una versione aggiornata della mappa del sito.

Dopodiché è solo un gioco d'attesa. I motori di ricerca rivisiteranno il tuo sito e, si spera, ripristineranno rapidamente il tuo posto nelle classifiche.

Prendi il controllo del tuo WordPress robots.txt

Con i file robots.txt, un grammo di prevenzione è meglio di mezzo chilo di cura. Soprattutto sui siti Web più grandi, un file difettoso può compromettere il posizionamento, il traffico e le entrate.

Per questo motivo, qualsiasi modifica al file robots.txt del tuo sito dovrebbe essere eseguita con attenzione e con test approfonditi. La consapevolezza degli errori che si possono commettere è il primo passo per prevenirli.

Quando commetti un errore, cerca di non farti prendere dal panico. Diagnostica cosa c'è che non va, correggi eventuali errori e invia nuovamente la mappa del sito per far sì che il tuo sito venga nuovamente scansionato.

Infine, assicurati che le prestazioni non siano il motivo per cui i motori di ricerca non eseguono correttamente la scansione del tuo sito. Prova subito WP Rocket per rendere il tuo sito più veloce all'istante!