Wie kann man die WordPress Robots.txt einfach optimieren?

Veröffentlicht: 2023-02-28Einführung

Es gibt zahlreiche Techniken, um die SEO Ihrer Website zu verbessern. Die Optimierung der WordPress Robots.txt ist eine der besten Methoden. Da Suchmaschinen Ihre Website scannen können, ist die Datei Robots.txt als potentes SEO-Tool bekannt. Infolgedessen können Sie die SEO Ihrer Website frei verbessern, indem Sie die Robots.txt-Datei optimieren. Einige Ansätze zur Optimierung der WordPress Robots.txt zu diesem Thema stellen wir heute in diesem Blogbeitrag anschaulich vor.

Die Definition der Robots.txt-Datei

Nachfolgend finden Sie eine Zusammenfassung der Robots.txt-Datei von WordPress.

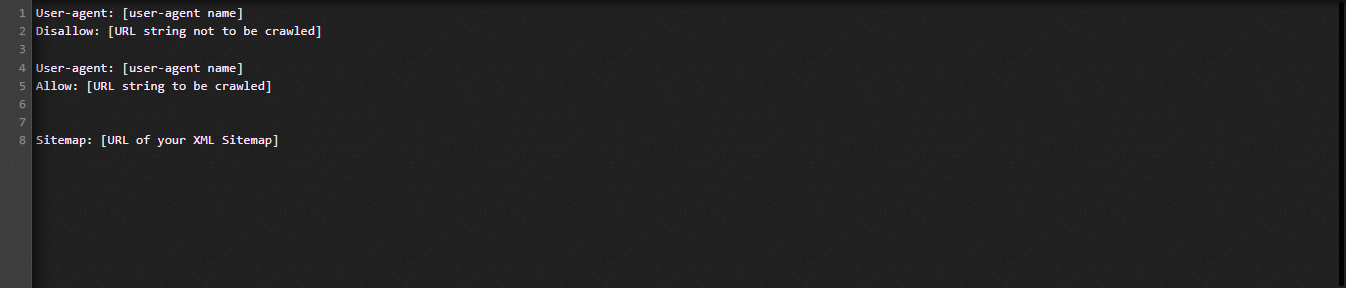

Schauen wir uns nun die grundlegende Struktur der Datei Robot.txt an:

Lassen Sie uns die in der Robots.txt-Datei verwendeten Begriffe für Sie definieren:

- User-Agent: Der Name des Crawlers

- Nicht zulassen: Verhindert, dass die Seiten, Ordner oder Dateien einer Website gecrawlt werden.

- Zulassen: Aktiviert das Crawlen von Verzeichnissen, Dateien und Seiten

- Sitemap, falls vorhanden: Zeigen Sie die Position der Sitemap an: Stellen Sie eine Zahl oder einen Buchstaben dar.

- *: Steht für Zahl oder Zeichen

- $: Sie können es verwenden, um Webseiten einzuschränken, die eine bestimmte Erweiterung enthalten, indem Sie bis zum Ende der Zeile stehen.

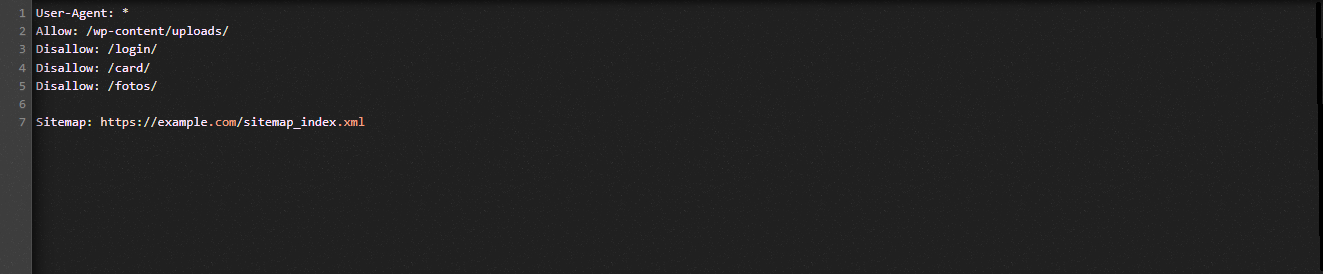

Schauen wir uns die folgende Abbildung an, um Ihnen beim Verständnis zu helfen:

Wir erlauben Suchmaschinen, die Dateien im WordPress-Upload-Ordner im Robot.txt-Beispiel zu crawlen.

Wir beschränken jedoch den Zugriff von Suchmaschinen auf die Login-, Karten- und Fotoordner.

Schließlich stellen wir ihm die URL der Sitemap zur Verfügung.

Warum sollte eine Robots.txt-Datei für Ihre WordPress-Website erstellt werden?

Ohne eine Robots.txt-Datei werden Suchmaschinen immer noch jede Seite einer Website crawlen und indizieren. Trotzdem werden sie das gesamte Material auf Ihrer Website durchsuchen und nicht nur die von Ihnen angegebenen Ordner oder Seiten.

Sie sollten aus zwei Hauptgründen eine Robots.txt-Datei für Ihre Website erstellen. Zunächst einmal können Sie mit seiner Hilfe mühelos alle Informationen auf Ihrer Website verwalten. Ob Seiten oder Verzeichnisse gecrawlt oder indexiert werden sollen, bleibt Ihnen überlassen. Das bedeutet, dass Seiten wie Plugin-Dateien, Admin-Seiten oder Themenverzeichnisse nicht von Suchmaschinen gecrawlt werden. Infolgedessen wird die Indexladegeschwindigkeit Ihrer Website verbessert.

Die Anforderung, zu verhindern, dass nicht benötigte Beiträge oder Seiten von Suchmaschinen indexiert werden, ist die andere Begründung. Sie können daher einfach und bequem verhindern, dass eine WordPress-Seite oder ein Beitrag in den Suchergebnissen angezeigt wird.

So optimieren Sie die WordPress Robots.txt effizienter

In diesem Anleitungsblog zeigen wir Ihnen, wie Sie die Robots.txt-Datei auf Ihrer WordPress-Website mit zwei verschiedenen Methoden erstellen und verbessern:

- Änderungen an der Robots.txt-Datei mit einem Plugin vornehmen: All in One SEO

- Manuelles Bearbeiten der Robots.txt-Datei mit FTP

Um die Robots.txt-Datei effektiver zu machen, verwenden Sie das All-in-One-SEO-Plugin.

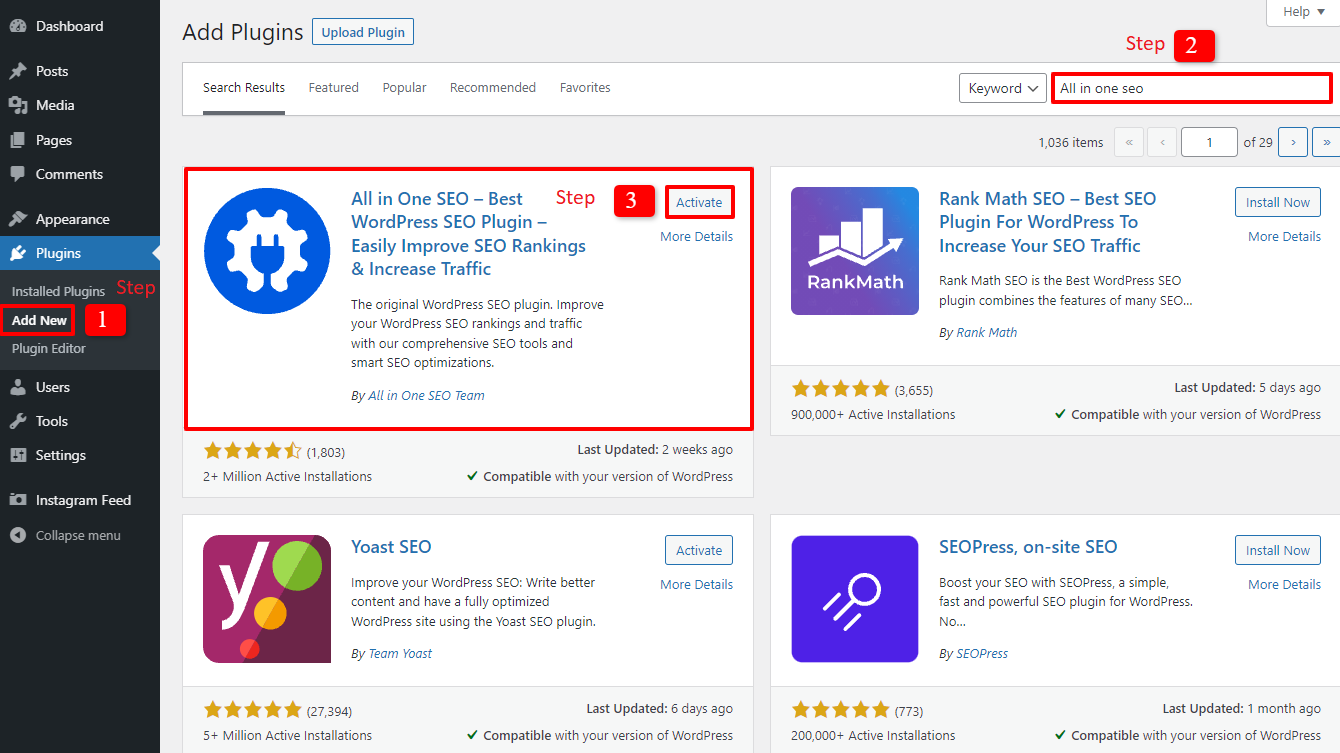

Auf dem WordPress-Markt sind mehrere WordPress-SEO-Plugins verfügbar, die Ihnen bei diesem Problem helfen. Aber in diesem Artikel haben wir uns entschieden, All in One SEO, ein beliebtes Plugin mit über 2 Millionen Benutzern, zu verwenden, um Ihnen zu helfen.

Lassen Sie uns es zuerst installieren, indem Sie Plugins -> Add New auswählen. Suchen Sie dann nach dem Namen des Plugins, installieren Sie es und aktivieren Sie es dann.

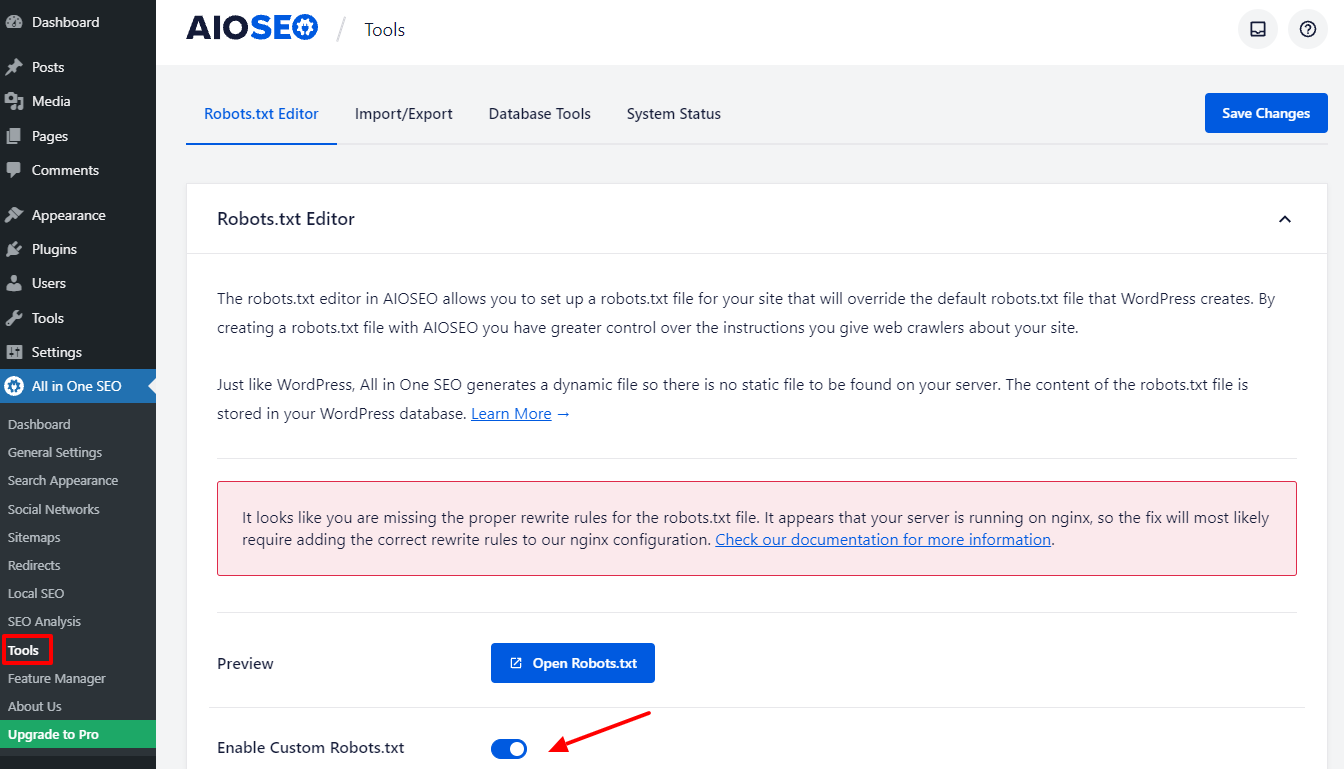

Nach einigen einfachen Schritten kehren Sie zum Admin-Dashboard zurück. Gehen Sie jetzt zu All in One SEO -> Tools .

Lassen Sie uns die Schaltfläche Enable Custome Robots.txt im Abschnitt Robots.txt-Editor umschalten, um sie zu aktivieren. Nach dem Einschalten können Sie daher die Standarddatei Robots.txt in WordPress bearbeiten.

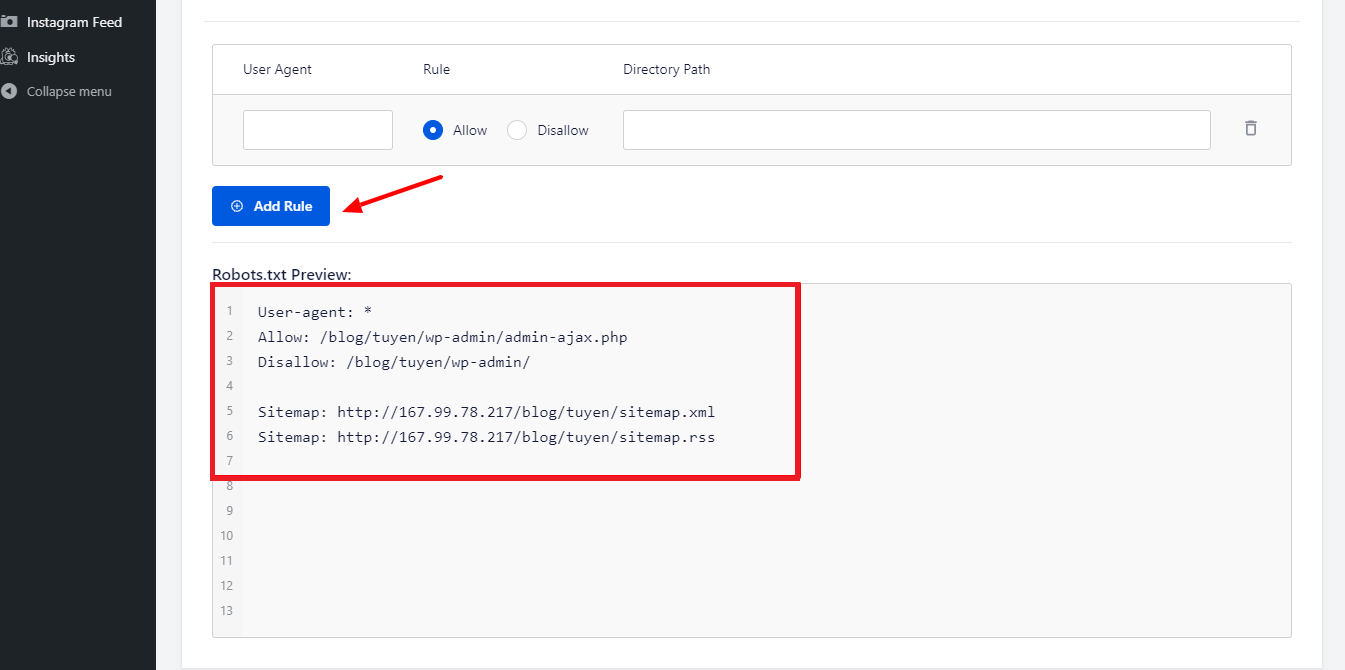

Wenn wir nach unten scrollen, werden Sie feststellen, dass dieses Plugin ein Feld mit einer Vorschau der Robots.txt-Datei anzeigt. Dies sind die Standardregeln von WordPress.

Indem Sie auf die Schaltfläche Regel hinzufügen klicken, können Sie weitere Ihrer eigenen spezifischen Regeln hinzufügen, um die SEO Ihrer Website zu unterstützen.

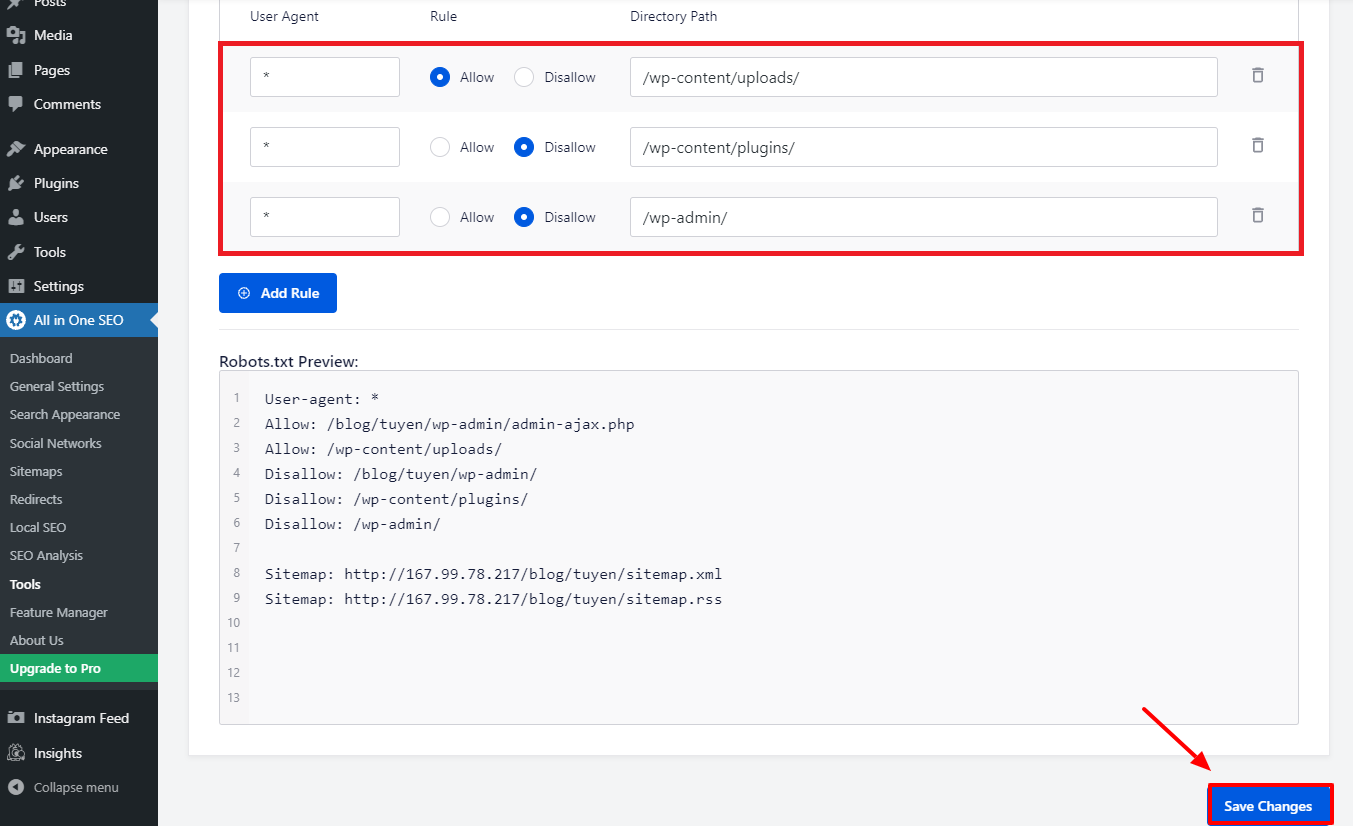

Lassen Sie uns ein * in das User-Agent- Feld eingeben, um die Regel auf alle User-Agents anzuwenden und eine neue Regel hinzuzufügen.

Sie müssen nur Zulassen oder Verbieten auswählen, damit die Such-Bots in der folgenden Phase crawlen können.

Vergessen Sie nicht, danach den Dateinamen oder den Verzeichnispfad in das Feld Verzeichnispfad einzugeben.

Wenn Sie mit all Ihren Einstellungen fertig sind, klicken Sie auf die Schaltfläche Änderungen speichern .

Alle zusätzlichen Regeln, die Sie bereits hinzugefügt haben, werden jetzt sofort auf die Datei Robots.txt angewendet.

Ändern und optimieren Sie die WordPress Robots.txt manuell über FTP

Dies ist ein anderer Ansatz zur Optimierung von WordPress Robots.txt, der Ihnen gefallen könnte. Dazu müssen Sie die Datei Robots.txt mit einem FTP-Client bearbeiten.

Um den FPT-Client bequem nutzen zu können, stellen wir zunächst eine Verbindung zu Ihrem WordPress-Hosting-Konto her. Sie können die Robots.txt-Datei im Stammordner Ihrer Website leicht bemerken, wenn Sie darauf zugreifen. Lassen Sie uns View/Edit auswählen, indem Sie mit der rechten Maustaste klicken.

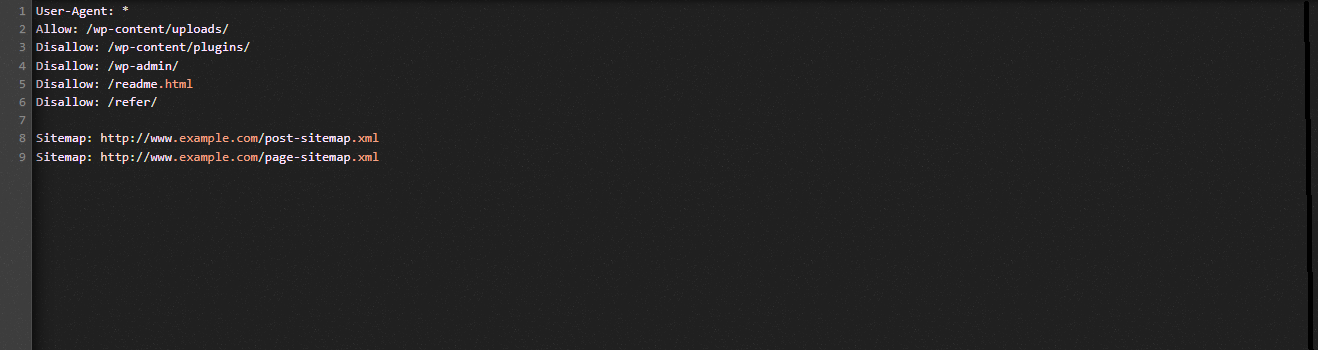

Andererseits haben Sie wahrscheinlich nichts, wenn Sie es nicht finden können. Lassen Sie uns also zunächst eine Robots.txt-Datei für Ihre Website erstellen, indem Sie mit der rechten Maustaste Neue Datei erstellen auswählen.

Die Robots.txt-Datei ist eine einfache Textdatei, sodass Sie sie herunterladen und mit einem einfachen Texteditor wie Notepad oder TextEdit bearbeiten können. Sie müssen es danach einfach wieder in den Stammordner Ihrer Website hochladen. Scheint einfach, meinst du nicht?

Stellen Sie sicher, dass die Robots.txt-Datei Ihrer WordPress-Site funktioniert.

Ihre Robots.txt-Datei muss getestet werden, nachdem Sie sie bereits vorbereitet und konfiguriert haben, damit alle Probleme identifiziert und gemeldet werden können. Daher müssen Sie es mit einem Robots.txt-Testertool testen. Probieren Sie die Google Search Console aus, da wir sie sehr empfehlen.

Sie müssen sicherstellen, dass Ihre Website mit der Google Search Console verknüpft ist, wenn Sie diesen Dienst nutzen möchten. Anschließend können Sie das Robots Testing Tool verwenden, indem Sie die Eigenschaft aus der Auswahlliste auswählen. Die Robots.txt-Datei für Ihre Website wird nun automatisch hinzugefügt. Es wird Sie warnen, wenn es einen Fehler gibt.

Abschluss

Insgesamt besteht das Hauptziel der Optimierung der Robots.txt-Datei darin, Such-Bots daran zu hindern, auf Seiten zuzugreifen, die für die breite Öffentlichkeit nicht erforderlich sind, einschließlich Plugin-Ordner oder Admin-Ordner. Infolgedessen hilft das Blockieren von WordPress-Tags, Kategorien oder Archivseiten Ihrer SEO nicht. Mit anderen Worten, um eine perfekte Robots.txt-Datei für Ihre WordPress-Seite zu erstellen, sollten Sie sich an das folgende Muster halten.

Wir hoffen, dass Sie den heutigen Blogbeitrag hilfreich finden, um die WordPress Robots.txt zu optimieren. Denken Sie daran, es an Ihre Bekannten und andere Webmaster weiterzuleiten. Bitte hinterlassen Sie auch unten eine Bemerkung, wenn Sie Fragen haben. Daher werden wir Ihnen so schnell wie möglich antworten. Es ist an der Zeit, die WordPress Robots.txt zu optimieren. Bis zu den zukünftigen Blogs, pass auf dich auf.

Übrigens haben wir eine Menge zeitgemäßer, ansprechender und kostenloser WordPress-Themes , die diese nützliche Funktion vollständig unterstützen. Lassen Sie uns sie besuchen und einen von ihnen bitten, Ihre Website neu zu gestalten