14 häufige WordPress Robots.txt-Fehler, die Sie vermeiden sollten

Veröffentlicht: 2025-01-14Robots.txt ist eine leistungsstarke Serverdatei, die Suchcrawlern und anderen Bots mitteilt, wie sie sich auf Ihrer WordPress-Website verhalten sollen. Es kann die Suchmaschinenoptimierung (SEO) Ihrer Website sowohl positiv als auch negativ stark beeinflussen.

Aus diesem Grund sollten Sie wissen, was diese Datei ist und wie Sie sie verwenden. Andernfalls könnten Sie Ihre Website beschädigen oder zumindest einen Teil ihres Potenzials ungenutzt lassen.

Um Ihnen zu helfen, dieses Szenario zu vermeiden, gehen wir in diesem Beitrag ausführlich auf die robots.txt-Datei ein. Wir definieren, was es ist, welchen Zweck es hat, wie Sie Ihre Datei finden und verwalten und was sie enthalten sollte. Anschließend gehen wir auf die häufigsten Fehler ein, die Menschen mit ihrer WordPress-Robots.txt-Datei machen, auf Möglichkeiten, sie zu vermeiden und auf die Wiederherstellung, wenn Sie feststellen, dass Sie einen Fehler gemacht haben.

Was ist die WordPress robots.txt?

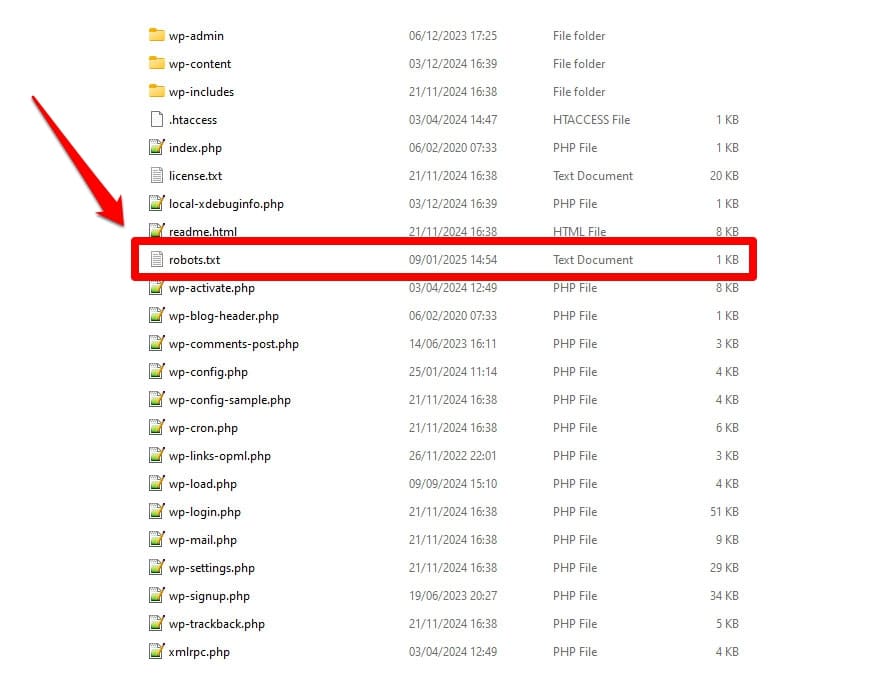

Wie bereits erwähnt, handelt es sich bei robots.txt um eine Serverkonfigurationsdatei. Sie finden es normalerweise im Stammordner Ihres Servers.

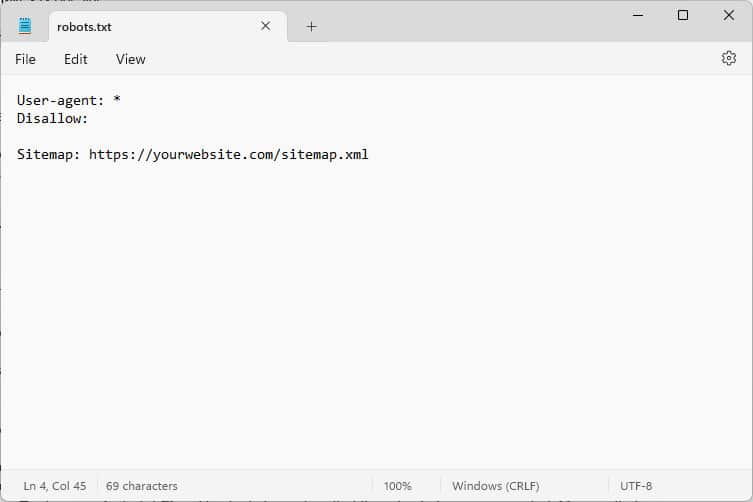

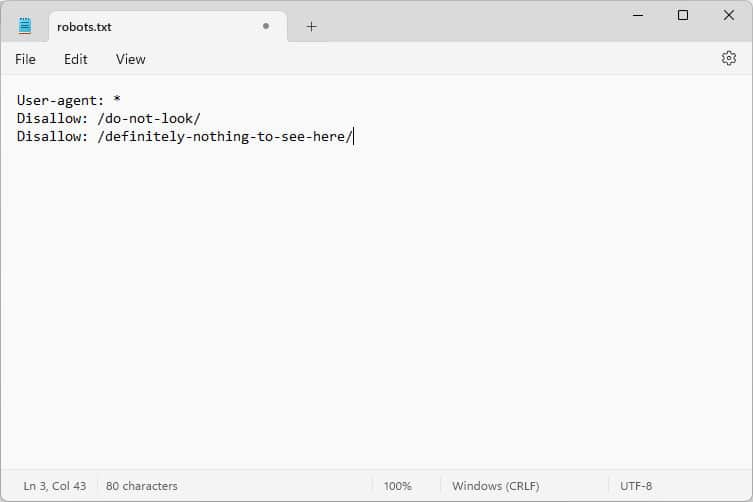

Wenn Sie es öffnen, sieht der Inhalt etwa so aus:

Bei diesen Codeteilen handelt es sich um Anweisungen, die Bots, die Ihre Website besuchen, mitteilen, wie sie sich dort verhalten sollen – insbesondere, auf welche Teile Ihrer Website sie zugreifen sollen und auf welche nicht.

Welche Bots, fragen Sie?

Die häufigsten Beispiele sind automatische Crawler von Suchmaschinen, die nach Webseiten zum Indizieren oder Aktualisieren suchen, aber auch Bots von KI-Modellen und anderen automatisierten Tools.

Welche Anweisungen können Sie mit dieser Datei geben?

Robots.txt kennt grundsätzlich vier Schlüsselanweisungen:

- Benutzeragent – Definiert, für wen, d. h. für welche Gruppe oder einzelne Bots die folgenden Regeln gelten.

- Nicht zulassen – Gibt die Verzeichnisse, Dateien oder Ressourcen an, auf die der Benutzeragent nicht zugreifen darf.

- Zulassen – Kann zum Einrichten von Ausnahmen verwendet werden, um beispielsweise den Zugriff auf einzelne Ordner oder Ressourcen in ansonsten verbotenen Verzeichnissen zu erlauben.

- Sitemap – Verweist Bots auf den URL-Speicherort der Sitemap einer Website.

Nur „User-Agent“ und „Disallow“ sind zwingend erforderlich, damit die Datei ihre Aufgabe erfüllen kann. Die anderen beiden Anweisungen sind optional. So blockieren Sie beispielsweise den Zugriff von Bots auf Ihre Website:

User-agent: * Disallow: /Das Sternchen bedeutet, dass die folgende Regel für alle Benutzeragenten gilt. Der Schrägstrich nach „Disallow“ besagt, dass alle Verzeichnisse auf dieser Site tabu sind. Dies ist die robots.txt-Datei, die Sie normalerweise auf Entwicklungsseiten finden, die nicht von Suchmaschinen indiziert werden sollen.

Sie können aber auch Regeln für einzelne Bots einrichten:

User-agent: Googlebot Allow: /private/resources/Es ist wichtig zu beachten, dass robots.txt nicht bindend ist. Nur Bots von Organisationen, die sich an das Robots Exclusion Protocol halten, werden dessen Anweisungen befolgen. Schädliche Bots, die beispielsweise nach Sicherheitslücken auf Ihrer Website suchen, können und werden diese ignorieren, und Sie müssen zusätzliche Maßnahmen gegen sie ergreifen.

Selbst Organisationen, die sich an den Standard halten, werden einige Richtlinien ignorieren. Wir werden weiter unten über Beispiele dafür sprechen.

Warum ist robots.txt wichtig?

Es ist nicht zwingend erforderlich, dass Ihre WordPress-Site über eine robots.txt-Datei verfügt. Ihre Website funktioniert auch ohne diese Funktion und Suchmaschinen bestrafen Sie nicht dafür, dass Sie sie nicht haben. Wenn Sie jedoch eines einschließen, können Sie:

- Halten Sie Inhalte wie Anmeldeseiten oder bestimmte Mediendateien aus den Suchergebnissen fern.

- Verhindern Sie, dass Suchcrawler Ihr Crawling-Budget für unwichtige Teile Ihrer Website verschwenden und möglicherweise Seiten ignorieren, die sie indexieren sollen.

- Verweisen Sie Suchmaschinen auf Ihre Sitemap, damit sie den Rest Ihrer Website einfacher erkunden können.

- Schützen Sie Serverressourcen, indem Sie verschwenderische Bots fernhalten.

All dies trägt dazu bei, Ihre Website zu verbessern, insbesondere Ihre SEO. Deshalb ist es wichtig, dass Sie wissen, wie man robots.txt verwendet.

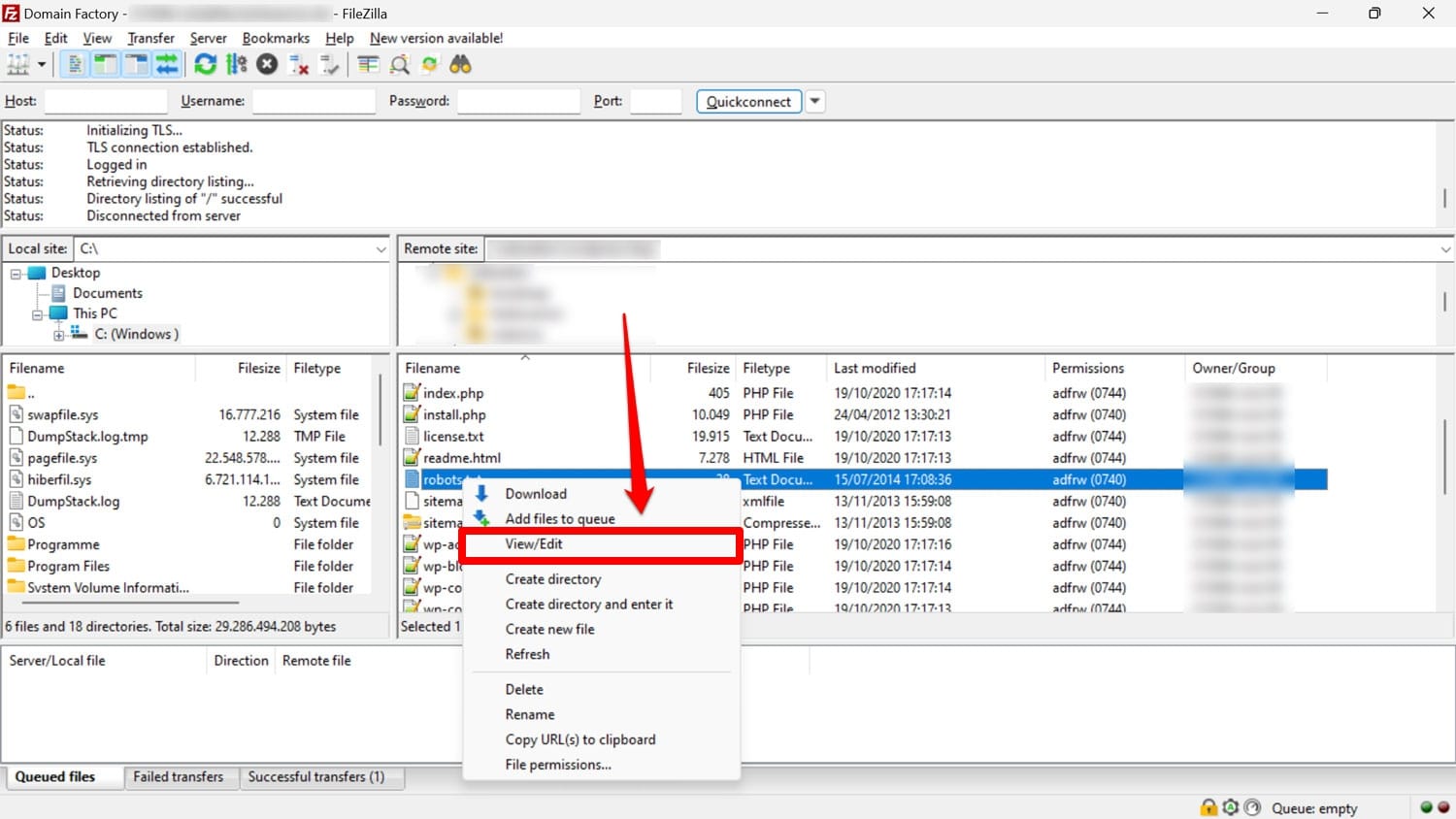

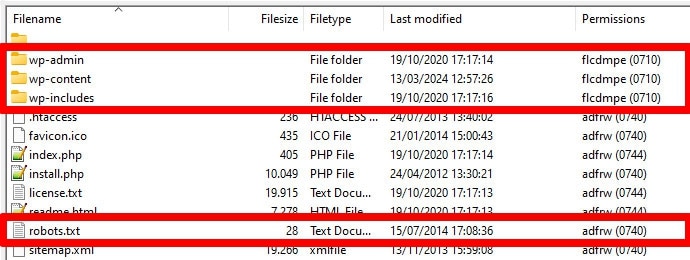

So finden, bearbeiten und erstellen Sie Ihre WordPress robots.txt

Wie bereits erwähnt, liegt robots.txt normalerweise im Stammordner Ihrer Website auf dem Server. Dort können Sie mit einem FTP-Client wie FileZilla darauf zugreifen und es mit einem beliebigen Texteditor bearbeiten.

Wenn Sie noch keine haben, können Sie einfach eine leere Textdatei erstellen, sie „robots.txt“ nennen, sie mit Anweisungen füllen und hochladen.

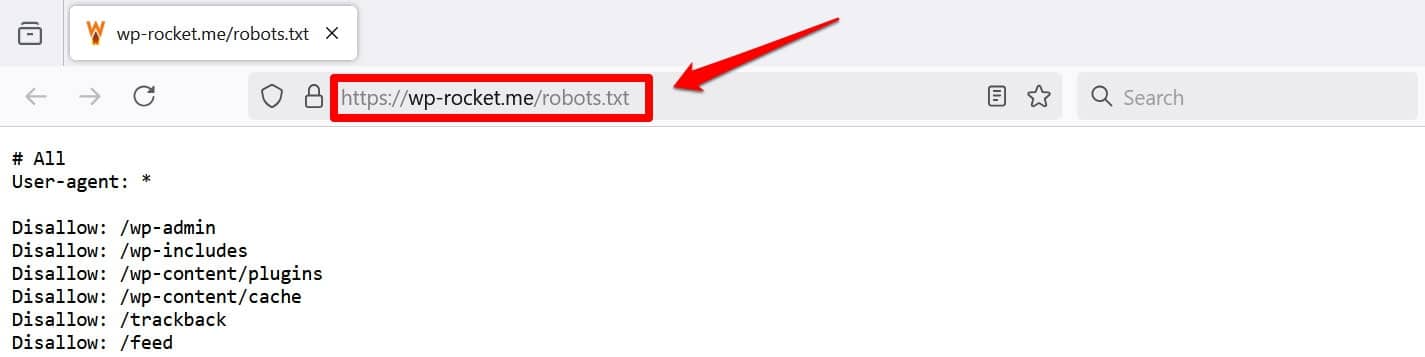

Eine andere Möglichkeit, Ihre Datei zumindest anzuzeigen, besteht darin, /robots.txt zu Ihrer Domain hinzuzufügen, z. B. https://wp-rocket.me/robots.txt.

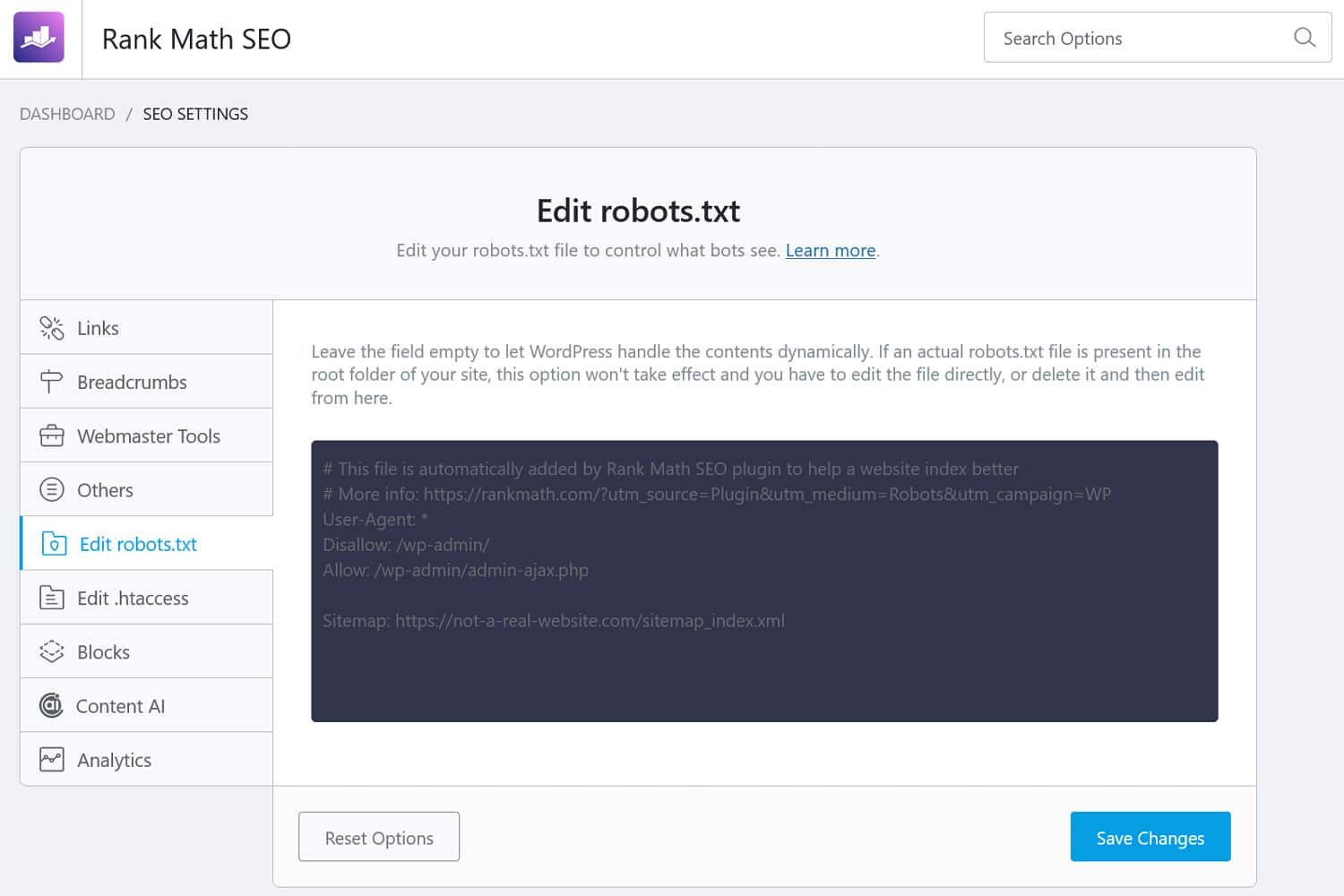

Darüber hinaus gibt es Möglichkeiten, über das WordPress-Backend auf die Datei zuzugreifen. Viele SEO-Plugins ermöglichen es Ihnen, sie über die Verwaltungsoberfläche anzuzeigen und häufig Änderungen daran vorzunehmen.

Alternativ können Sie auch ein Plugin wie WPCode verwenden.

Wie sieht eine gute WordPress robots.txt-Datei aus?

Es gibt keine allgemeingültige Antwort darauf, welche Anweisungen in der Datei Ihrer Website enthalten sein sollten. es hängt von Ihrem Setup ab. Hier ist ein Beispiel, das für viele WordPress-Websites sinnvoll ist:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://yourwebsite.com/sitemap.xmlDieses Beispiel erzielt mehrere Ergebnisse:

- Es blockiert den Zugriff auf den Admin-Bereich

- Ermöglicht den Zugriff auf wichtige Administratorfunktionen

- Stellt einen Sitemap-Speicherort bereit

Dieses Setup schafft ein Gleichgewicht zwischen Sicherheit, SEO-Leistung und effizientem Crawling.

Machen Sie diese 14 WordPress robots.txt-Fehler nicht

Wenn Ihr Ziel darin besteht, die robots.txt-Datei für Ihre eigene Website einzurichten und zu optimieren, achten Sie darauf, die folgenden Fehler zu vermeiden.

1. Ignorieren der internen WordPress robots.txt

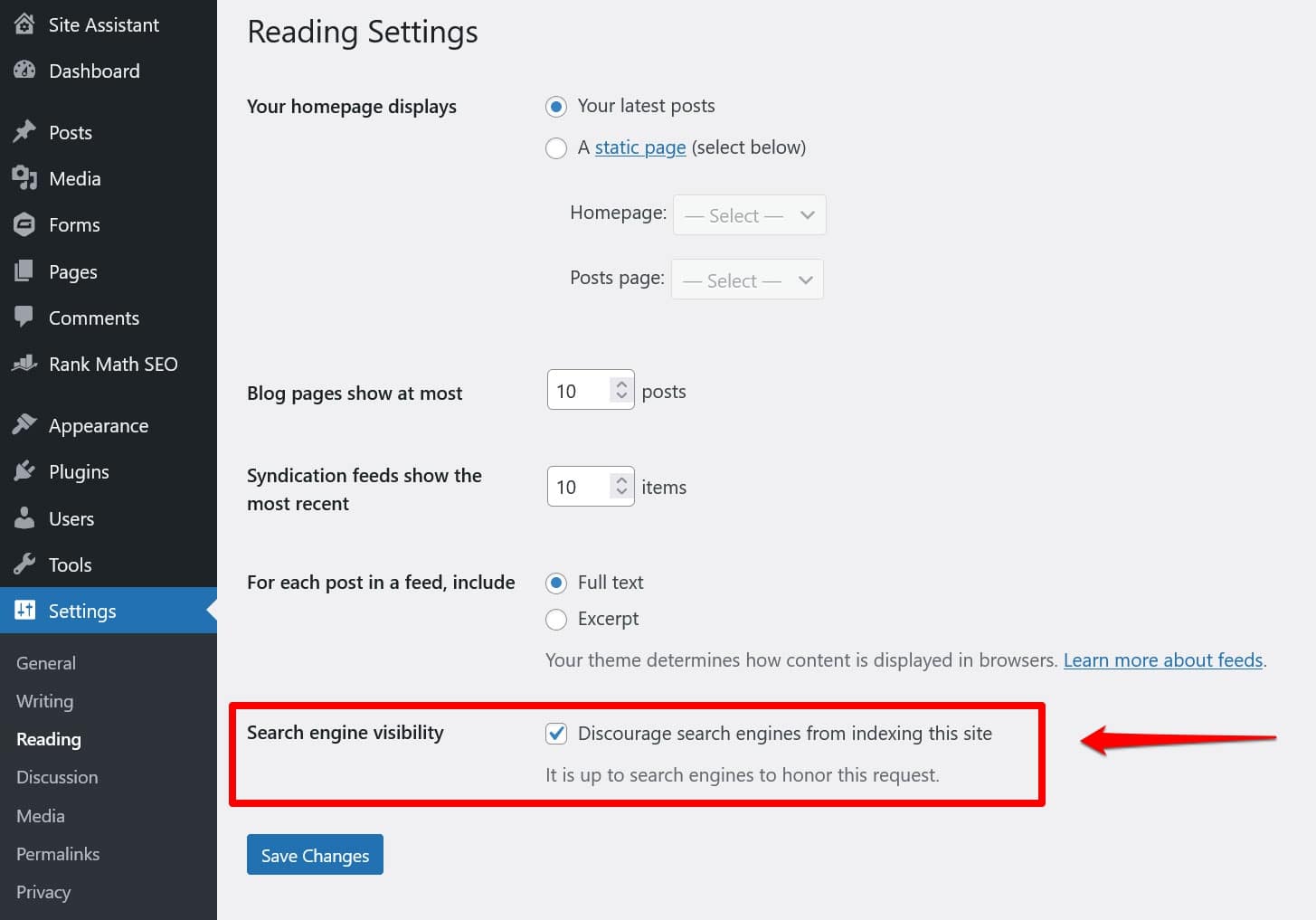

Auch wenn Sie keine „physische“ robots.txt-Datei im Stammverzeichnis Ihrer Website haben, verfügt WordPress über eine eigene virtuelle Datei. Dies ist besonders wichtig, wenn Sie feststellen, dass Suchmaschinen Ihre Website nicht indizieren.

In diesem Fall besteht eine gute Chance, dass Sie unter Einstellungen > Lesen die Option aktiviert haben, sie davon abzuhalten.

Dies fügt eine Anweisung ein, alle Suchcrawler in der virtuellen robots.txt fernzuhalten. Um es zu deaktivieren, deaktivieren Sie das Kontrollkästchen und speichern Sie es unten.

2. Platzieren Sie es am falschen Ort

Bots, insbesondere Suchcrawler, suchen nur an einem Ort nach Ihrer robots.txt-Datei – dem Stammverzeichnis Ihrer Website. Wenn Sie es an einer anderen Stelle ablegen, beispielsweise in einem Ordner, wird es nicht gefunden und ignoriert.

Ihr Stammverzeichnis sollte der Ort sein, an dem Sie landen, wenn Sie über FTP auf Ihren Server zugreifen, es sei denn, Sie haben WordPress in einem Unterverzeichnis abgelegt. Wenn Sie die Ordner wp-admin , wp-content und wp-includes sehen, sind Sie hier richtig.

3. Einschließlich veralteter Markierungen

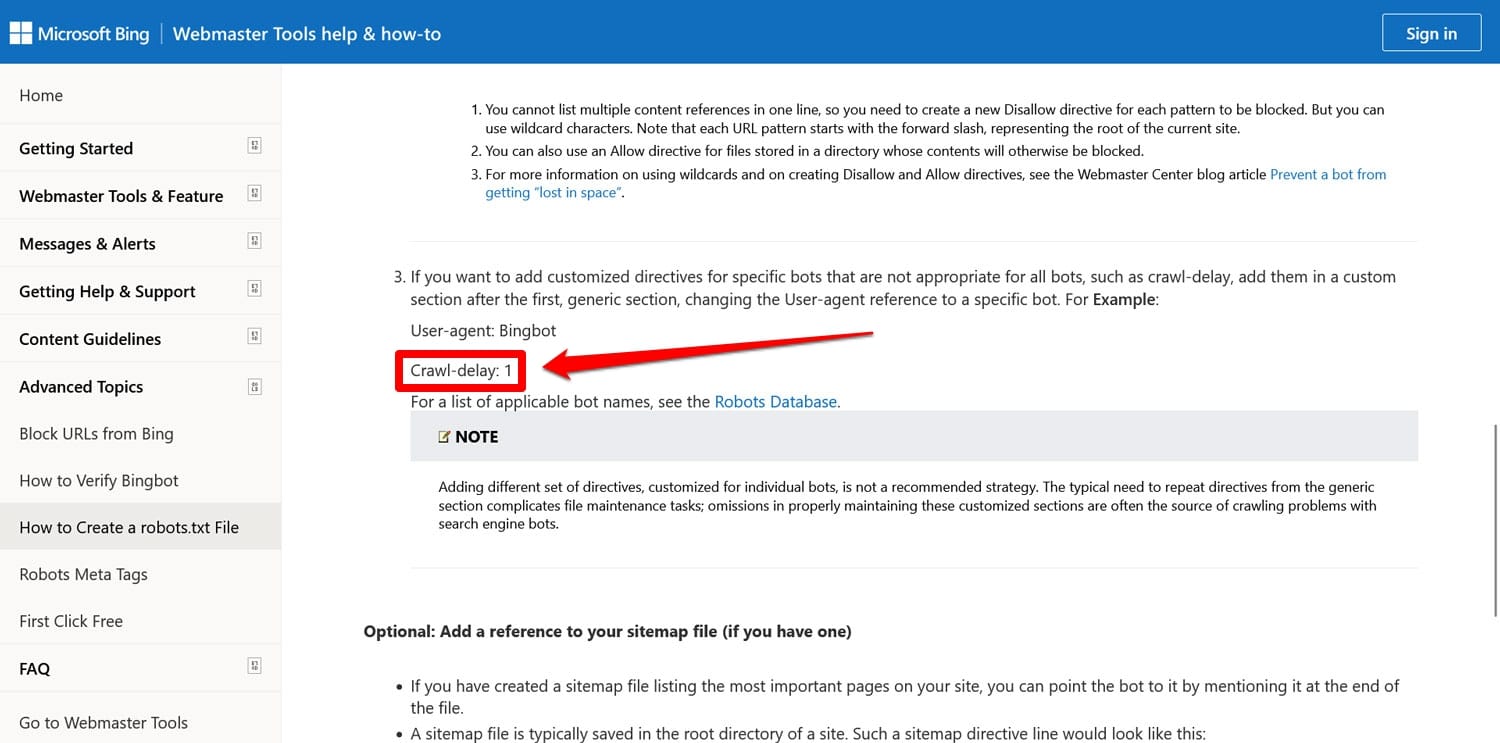

Neben den oben genannten Anweisungen gibt es zwei weitere, die Sie möglicherweise noch in den robots.txt-Dateien älterer Websites finden:

- Noindex – Wird verwendet, um URLs anzugeben, die Suchmaschinen auf Ihrer Website nicht indizieren sollen.

- Crawl-Delay – Eine Anweisung, die Crawler drosseln soll, damit sie die Ressourcen des Webservers nicht überlasten.

Beide Richtlinien werden mittlerweile ignoriert, zumindest von Google. Zumindest Bing respektiert immer noch die Crawl-Verzögerung.

In den meisten Fällen ist es am besten, diese Anweisungen nicht zu verwenden. Dies trägt dazu bei, Ihre Datei schlank zu halten und das Fehlerrisiko zu verringern.

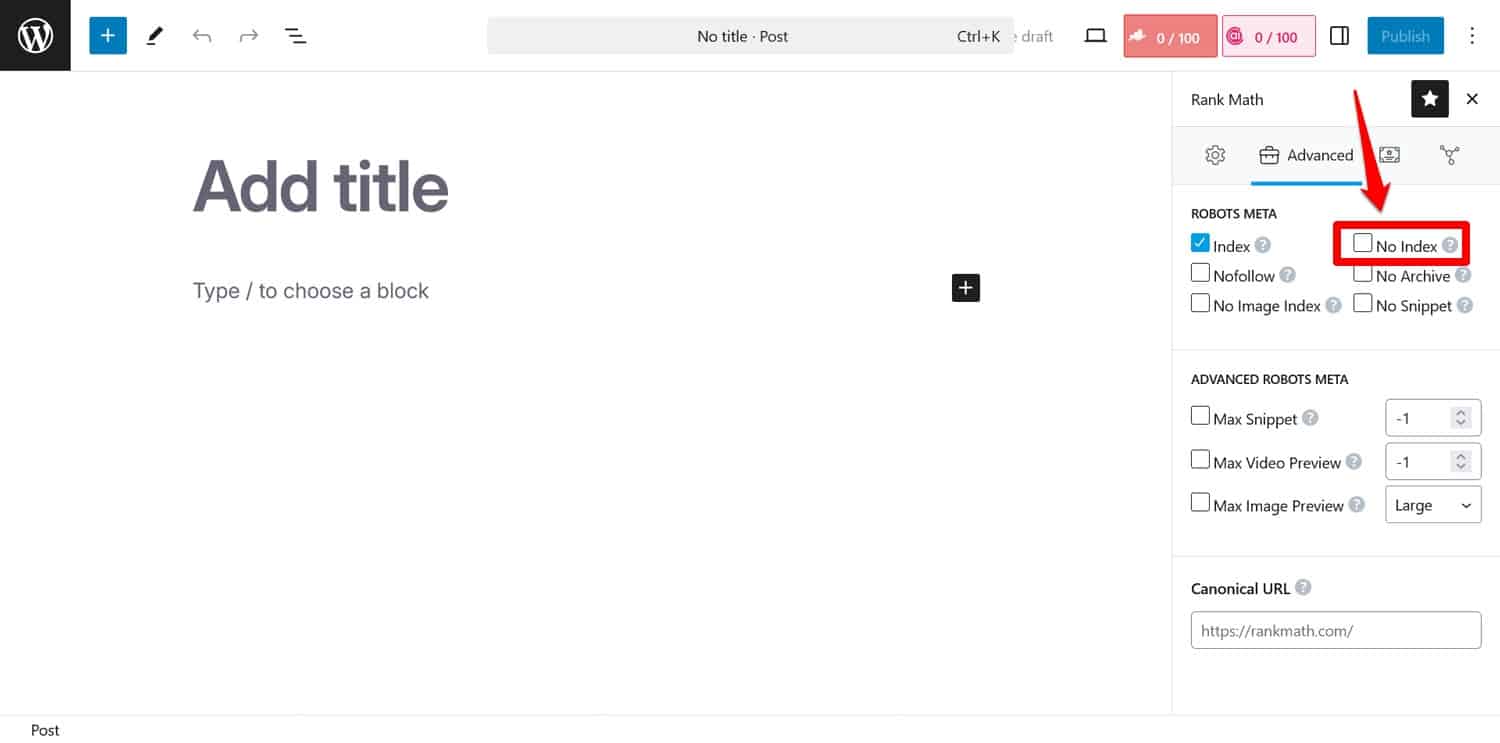

Tipp: Wenn Sie verhindern möchten, dass Suchmaschinen bestimmte Seiten indizieren, verwenden Sie stattdessen das Meta-Tag noindex . Sie können es mit einem SEO-Plugin pro Seite implementieren.

Wenn Sie Seiten über robots.txt blockieren, gelangen Crawler nicht zu dem Teil, in dem sie das Noindex -Tag sehen. Auf diese Weise wird Ihre Seite möglicherweise trotzdem indiziert, jedoch ohne Inhalt, was noch schlimmer ist.

4. Blockierung wesentlicher Ressourcen

Einer der Fehler, die Menschen machen, besteht darin, robots.txt zu verwenden, um den Zugriff auf alle Stylesheets (CSS-Dateien) und Skripte (JavaScript-Dateien) auf ihrer WordPress-Site zu blockieren, um das Crawling-Budget zu schonen.

Das ist jedoch keine gute Idee. Suchmaschinen-Bots rendern Seiten, um sie auf die gleiche Weise zu „sehen“, wie es Besucher tun. Dies hilft ihnen, den Inhalt zu verstehen und ihn entsprechend zu indizieren.

Durch das Blockieren dieser Ressourcen könnten Sie Suchmaschinen einen falschen Eindruck von Ihren Seiten vermitteln, was möglicherweise dazu führen könnte, dass diese nicht richtig indiziert werden oder ihr Ranking beeinträchtigt wird.

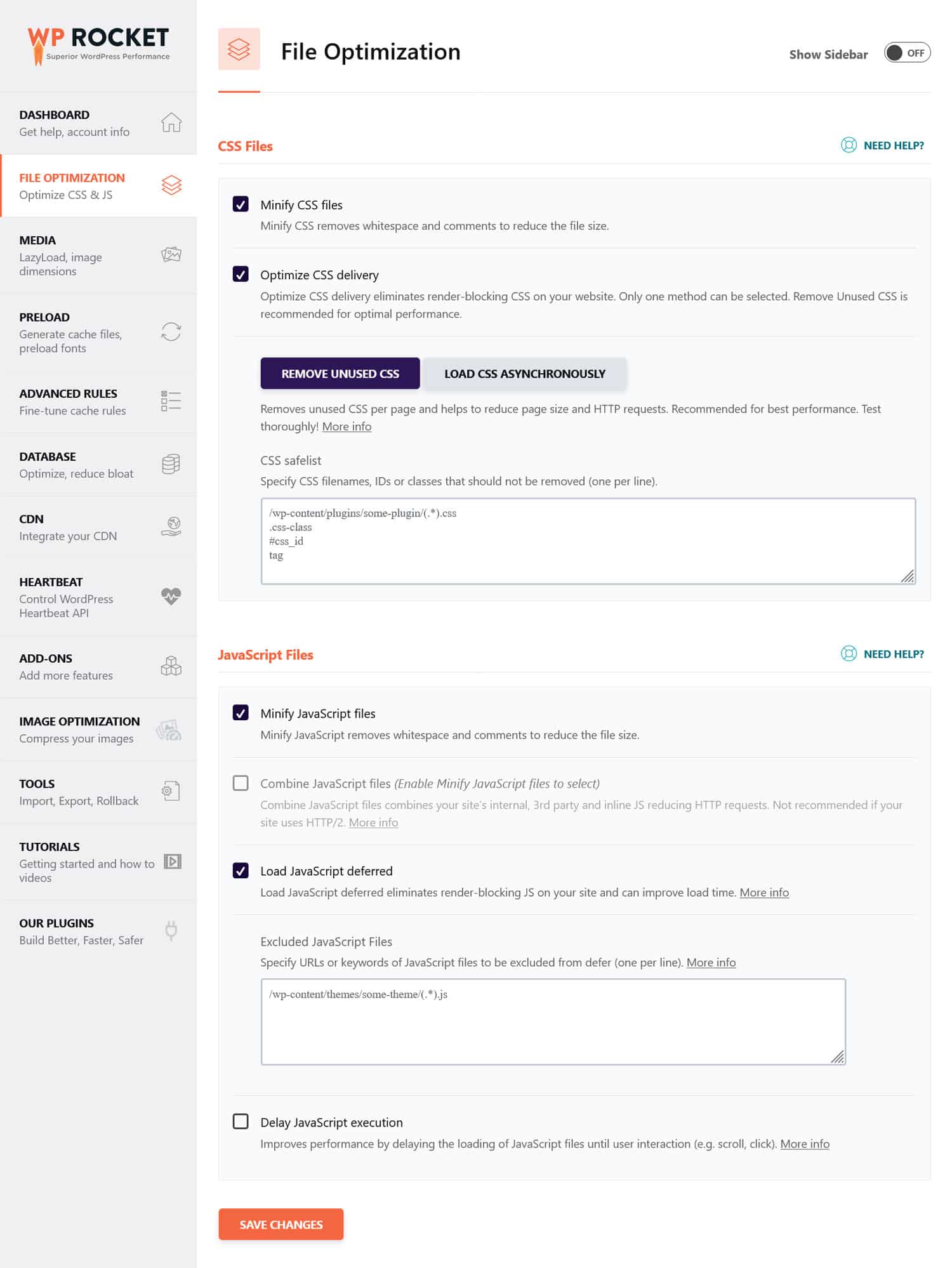

Wenn Sie der Meinung sind, dass CSS- und JavaScript-Dateien die Leistung Ihrer Website beeinträchtigen könnten, ist es besser, sie so zu optimieren, dass sie schnell geladen werden, sowohl für Bots als auch für regelmäßige Besucher. Sie können dies erreichen, indem Sie den Code minimieren und Website-Dateien komprimieren, damit sie schneller übertragen werden. Darüber hinaus ist es möglich, ihre Bereitstellung zu optimieren, indem ungenutzter Code entfernt und das Rendern blockierende Ressourcen zurückgestellt werden.

Tipp : Sie können diesen Vorgang vereinfachen, indem Sie ein Leistungs-Plugin wie WP Rocket verwenden. Dank der benutzerfreundlichen Oberfläche können Sie die Dateibereitstellung optimieren, indem Sie einige Kontrollkästchen im Menü „Dateioptimierung“ aktivieren.

WP Rocket verfügt außerdem über zusätzliche Funktionen zur Verbesserung der Website-Leistung, darunter:

- Caching mit einem dedizierten mobilen Cache

- Lazy Loading für Bilder und Videos

- Cache, Links, externe Dateien und Schriftarten werden vorab geladen

- Datenbankoptimierung

Darüber hinaus führt das Plugin viele Optimierungsschritte automatisch durch. Beispiele hierfür sind Browser- und Server-Caching, GZIP-Komprimierung und die Optimierung von Bildern über dem Falz zur Verbesserung des LCP. Auf diese Weise wird Ihre Website schneller, indem Sie einfach WP Rocket einschalten.

Das Plugin bietet außerdem eine 14-tägige Geld-zurück-Garantie, sodass Sie es risikofrei testen können.

5. Fehler beim Aktualisieren Ihrer Entwicklungs-robots.txt

Beim Erstellen einer Website fügen Entwickler normalerweise eine robots.txt-Datei ein, die allen Bots den Zugriff darauf verbietet. Das macht Sinn; Das Letzte, was Sie wollen, ist, dass Ihre unvollendete Website in den Suchergebnissen angezeigt wird.

Ein Problem tritt nur auf, wenn Sie diese Datei versehentlich auf Ihren Produktionsserver übertragen und Suchmaschinen daran hindern, auch Ihre Live-Website zu indizieren. Überprüfen Sie dies unbedingt, wenn Ihr Inhalt nicht in den Suchergebnissen angezeigt wird.

6. Kein Link zu Ihrer Sitemap

Wenn Sie von robots.txt aus auf Ihre Sitemap verlinken, erhalten Suchmaschinen-Crawler eine Liste aller Ihrer Inhalte. Dies erhöht Ihre Chancen, dass sie mehr als nur die aktuelle Seite indizieren, auf der sie gelandet sind.

Es genügt eine Zeile:

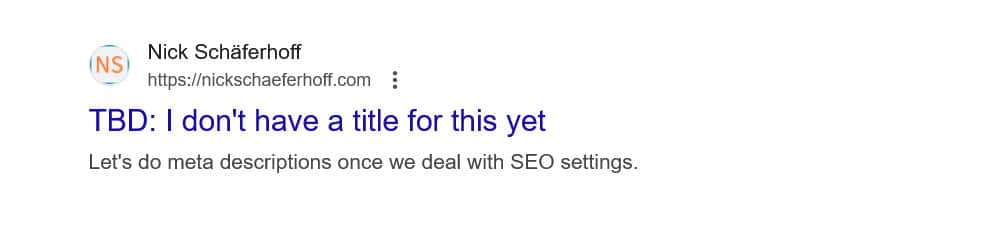

Sitemap: https://yourwebsite.com/sitemap.xmlJa, Sie können Ihre Sitemap auch direkt in Tools wie der Google Search Console einreichen.

Die Aufnahme in Ihre robots.txt-Datei ist jedoch dennoch sinnvoll, insbesondere für Suchmaschinen, deren Webmaster-Tools Sie nicht verwenden.

7. Verwendung widersprüchlicher Regeln

Ein häufiger Fehler beim Erstellen einer robots.txt-Datei besteht darin, Regeln hinzuzufügen, die sich widersprechen, wie zum Beispiel:

User-agent: * Disallow: /blog/ Allow: /blog/Die oben genannten Anweisungen lassen Suchmaschinen unklar, ob sie das Verzeichnis /blog/ crawlen sollen oder nicht. Dies führt zu unvorhersehbaren Ergebnissen und kann Ihrer SEO schaden.

| Sind Sie neugierig, was sich sonst noch nachteilig auf das Suchranking Ihrer Website auswirken kann und wie Sie dies vermeiden können? Erfahren Sie mehr darüber in unserem Leitfaden zu SEO-Fehlern. |

Um Konflikte zu vermeiden, befolgen Sie diese Best Practices:

- Benutzen Sie zuerst spezifische Regeln – Platzieren Sie spezifischere Regeln vor umfassenderen.

- Vermeiden Sie Redundanz – Fügen Sie keine gegensätzlichen Anweisungen für denselben Pfad ein.

- Testen Sie Ihre robots.txt-Datei – Verwenden Sie Tools, um zu bestätigen, dass sich die Regeln wie erwartet verhalten. Mehr dazu weiter unten.

8. Versuch, sensible Inhalte mit robots.txt zu verbergen

Wie bereits erwähnt, ist robots.txt kein Tool, um Inhalte aus den Suchergebnissen herauszuhalten. Da die Datei öffentlich zugänglich ist, kann die Verwendung zum Blockieren vertraulicher Inhalte möglicherweise unbeabsichtigt offenlegen, wo genau sich diese Inhalte befinden.

Tipp : Verwenden Sie das Noindex- Meta-Tag, um Inhalte aus den Suchergebnissen fernzuhalten. Schützen Sie außerdem sensible Bereiche Ihrer Website mit einem Passwort, um sie sowohl vor Robotern als auch vor unbefugten Benutzern zu schützen.

9. Unsachgemäßer Einsatz von Wildcards

Mit Platzhaltern können Sie große Gruppen von Pfaden oder Dateien in Ihre Anweisungen aufnehmen. Eines haben wir schon einmal kennengelernt, das *-Symbol. Es bedeutet „jede Instanz von“ und wird am häufigsten zum Einrichten von Regeln verwendet, die für alle Benutzeragenten gelten.

Ein weiteres Platzhaltersymbol ist $, das Regeln auf den Endteil einer URL anwendet. Sie können es beispielsweise verwenden, wenn Sie Crawlern den Zugriff auf alle PDF-Dateien auf Ihrer Website verweigern möchten:

Disallow: /*.pdf$Obwohl Platzhalter nützlich sind, können sie weitreichende Folgen haben. Gehen Sie vorsichtig damit um und testen Sie Ihre robots.txt-Datei immer, um sicherzustellen, dass Sie keine Fehler gemacht haben.

10. Verwechslung absoluter und relativer URLs

Hier ist der Unterschied zwischen absoluten und relativen URLs:

- Absolute URL – https://yourwebsite.com/private/

- Relative URL – /private/

Es wird empfohlen, in Ihren robots.txt-Anweisungen relative URLs zu verwenden, zum Beispiel:

Disallow: /private/Absolute URLs können Probleme verursachen, bei denen Bots die Anweisung ignorieren oder falsch interpretieren können. Die einzige Ausnahme ist der Pfad zu Ihrer Sitemap, der eine absolute URL sein muss.

11. Groß- und Kleinschreibung ignorieren

Bei Robots.txt-Anweisungen wird die Groß-/Kleinschreibung beachtet. Dies bedeutet, dass die folgenden beiden Richtlinien nicht austauschbar sind:

Disallow: /Private/ Disallow: /private/Wenn Sie feststellen, dass sich Ihre robots.txt-Datei nicht wie erwartet verhält, prüfen Sie, ob die falsche Groß- und Kleinschreibung das Problem sein könnte.

12. Falsche Verwendung von abschließenden Schrägstrichen

Ein abschließender Schrägstrich ist ein Schrägstrich am Ende einer URL:

- Ohne abschließenden Schrägstrich : /directory

- Mit abschließendem Schrägstrich : /directory/

In robots.txt wird entschieden, welche Site-Ressourcen erlaubt und welche nicht erlaubt sind. Hier ist ein Beispiel:

Disallow: /private/Die obige Regel verhindert, dass Crawler auf das „private“ Verzeichnis Ihrer Website und alles darin zugreifen. Nehmen wir andererseits an, Sie lassen den abschließenden Schrägstrich weg, etwa so:

Disallow: /privateIn diesem Fall würde die Regel auch andere Instanzen auf Ihrer Website blockieren, die mit „privat“ beginnen, wie zum Beispiel:

- https://yourwebsite.com/private.html

- https://yourwebsite.com/privateer

Daher ist es wichtig, präzise zu sein. Testen Sie im Zweifelsfall Ihre Datei.

13. Fehlende robots.txt für Subdomains

Jede Subdomain auf Ihrer Website (z. B. dev.ihrewebsite.com) benötigt eine eigene robots.txt-Datei, da Suchmaschinen sie als separate Webeinheiten behandeln. Ohne eine Datei besteht die Gefahr, dass Crawler Teile Ihrer Website indizieren, die Sie eigentlich verbergen wollten.

Wenn sich Ihre Entwicklungsversion beispielsweise in einem Ordner namens „dev“ befindet und eine Subdomain verwendet, stellen Sie sicher, dass sie über eine dedizierte robots.txt-Datei verfügt, um Suchcrawler zu blockieren.

14. Ihre robots.txt-Datei wird nicht getestet

Einer der größten Fehler bei der Konfiguration Ihrer WordPress-Robots.txt-Datei besteht darin, sie nicht zu testen, insbesondere nachdem Änderungen vorgenommen wurden.

Wie wir gesehen haben, können selbst kleine Fehler in der Syntax oder Logik erhebliche SEO-Probleme verursachen. Testen Sie daher immer Ihre robots.txt-Datei.

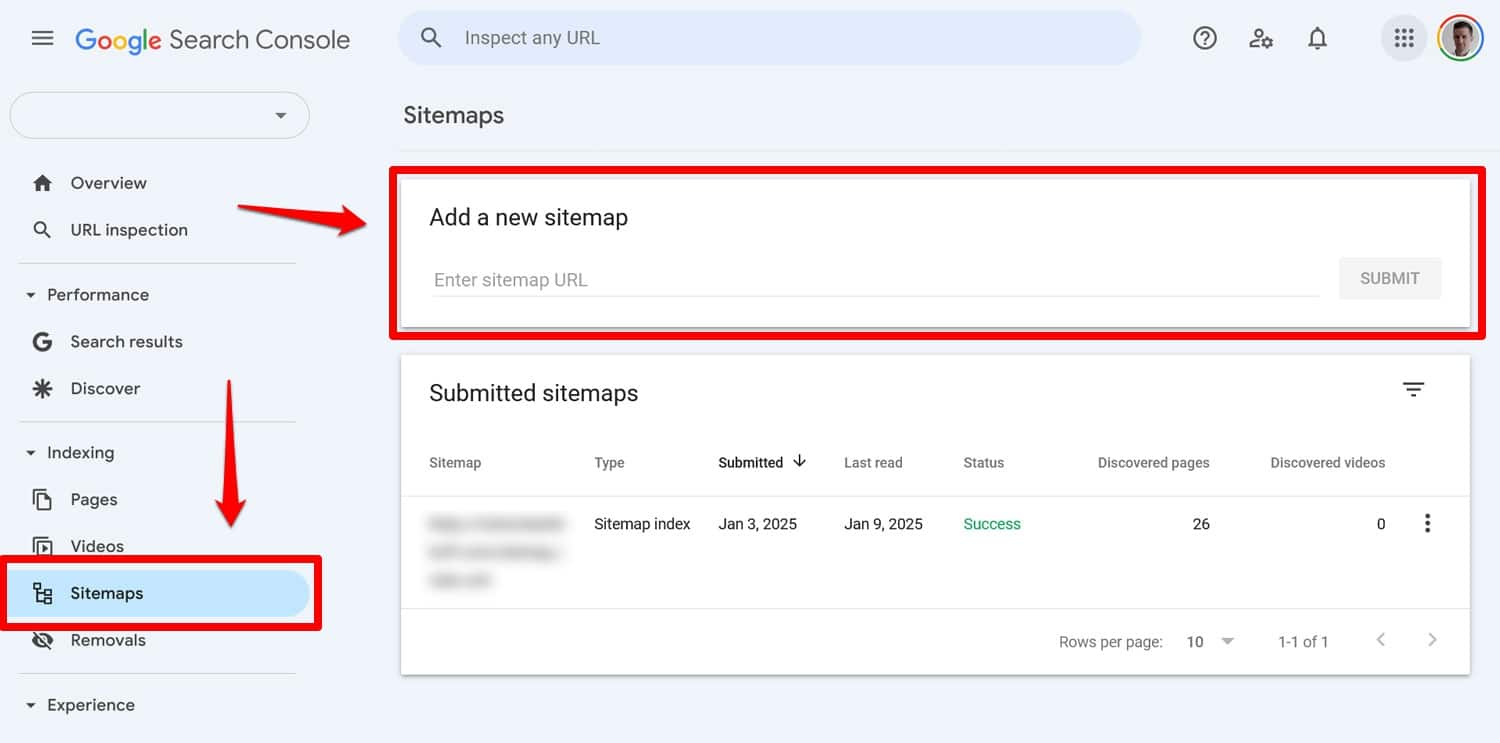

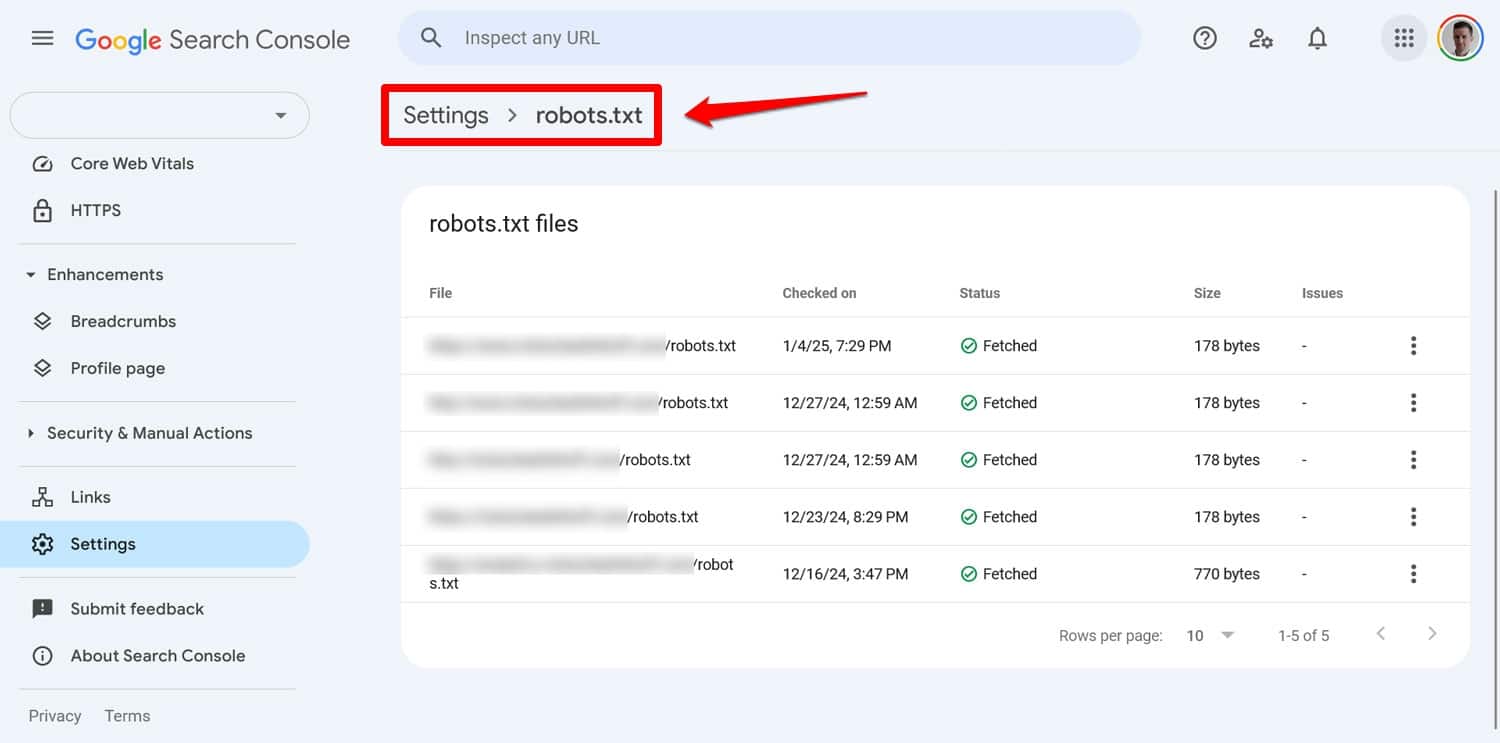

Sie können alle Probleme mit Ihrer Datei in der Google Search Console unter Einstellungen > robots.txt sehen.

Eine andere Möglichkeit besteht darin, das Kriechverhalten mit einem Tool wie Screaming Frog zu simulieren. Verwenden Sie außerdem eine Staging-Umgebung, um die Auswirkungen neuer Regeln zu überprüfen, bevor Sie sie auf Ihre Live-Site anwenden.

So beheben Sie einen robots.txt-Fehler

Fehler in Ihrer robots.txt-Datei können leicht passieren, aber glücklicherweise sind sie in der Regel auch leicht zu beheben, sobald Sie sie entdecken.

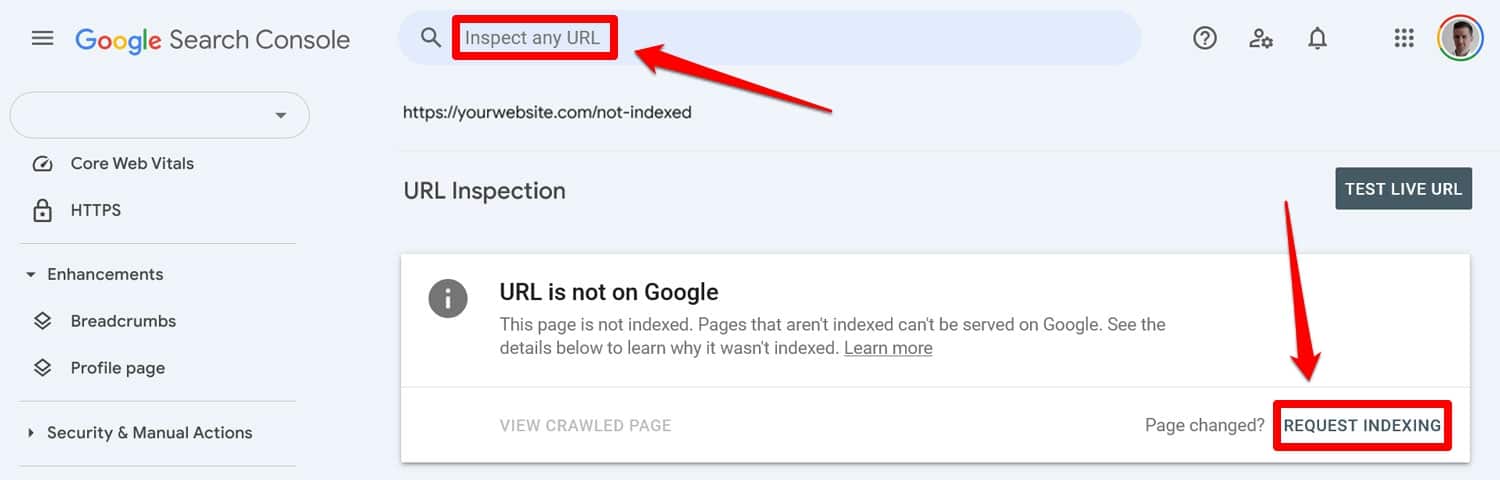

Führen Sie zunächst Ihre aktualisierte robots.txt-Datei über ein Testtool aus. Wenn Seiten zuvor durch robots.txt-Anweisungen blockiert wurden, geben Sie sie dann manuell in die Google Search Console oder die Bing Webmaster Tools ein, um eine Indexierung anzufordern.

Reichen Sie außerdem erneut eine aktuelle Version Ihrer Sitemap ein.

Danach ist es nur noch ein Wartespiel. Suchmaschinen werden Ihre Website erneut besuchen und Ihren Platz im Ranking hoffentlich schnell wiederherstellen.

Übernehmen Sie die Kontrolle über Ihre WordPress robots.txt

Bei robots.txt-Dateien ist ein Gramm Vorbeugung besser als ein Pfund Heilung. Insbesondere auf größeren Websites kann eine fehlerhafte Datei verheerende Auswirkungen auf Rankings, Traffic und Umsatz haben.

Aus diesem Grund sollten alle Änderungen an der robots.txt-Datei Ihrer Website sorgfältig und umfassend getestet werden. Sich darüber im Klaren zu sein, welche Fehler man machen kann, ist ein erster Schritt, um sie zu verhindern.

Wenn Sie einen Fehler machen, geraten Sie nicht in Panik. Diagnostizieren Sie, was falsch ist, korrigieren Sie etwaige Fehler und reichen Sie Ihre Sitemap erneut ein, damit Ihre Website erneut gecrawlt wird.

Stellen Sie abschließend sicher, dass die Leistung nicht der Grund dafür ist, dass Suchmaschinen Ihre Website nicht ordnungsgemäß crawlen. Probieren Sie WP Rocket jetzt aus, um Ihre Website sofort schneller zu machen!